S'adapter ou périr. Pourquoi le cloud pertube tout en même temps

Le cloud computing accélère le changement en transformant la façon dont les data centers déploient, développent et consomment tout ce qui leur passe entre les mains (logiciels et systèmes) et en transformant la manière de proposer leurs services et produits à leurs clients.

Regardons de plus près quelques unes de ces nouvelles technologies et voyons comment vous allez en adopter certaines, inconsciemment ou pas.C'est moi, ou il y a bien eu une explosion de mots à la mode ces temps-ci ? Ne vous méprenez pas, l'industrie informatique innove toujours à une cadence soutenue mais là il semble que les choses évoluent plus rapidement et qu'un changement fondamental est en train de s'opérer, et c'est au cloud qu'on peut l'attribuer.

Le cloud computing n'est pas nouveau, mais en 2014 il s'est imposé

Le cloud computing accélère le changement en transformant la façon dont les data centers déploient, développent et consomment tout ce qui leur passe entre les mains (logiciels et systèmes) et en transformant la manière de proposer leurs services et produits à leurs clients.Regardons de plus près quelques unes de ces nouvelles technologies et voyons comment vous allez en adopter certaines, inconsciemment ou pas.

Software-Defined Networking (SDN) - C'est quoi au juste ?

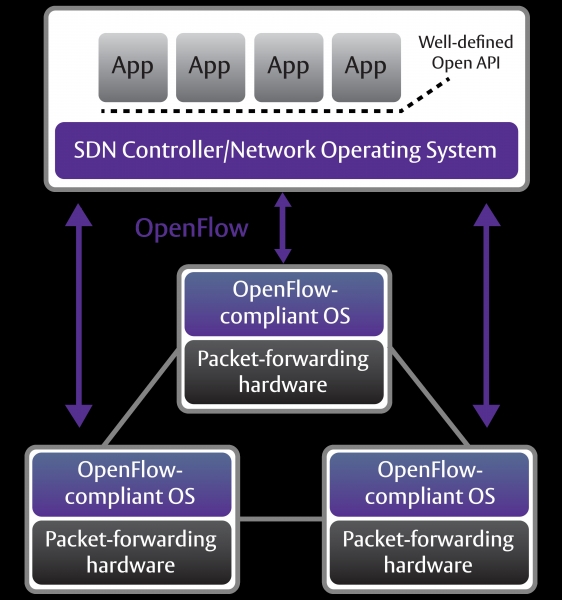

Il existe plusieurs définitions du SDN, en partie parce que c'est une nouvelle technologie et que sa signification varie selon les entreprises. Avant que le marché ne devienne mature, cette confusion va certainement persister, au moins pendant quelque temps. L'explication suivante est une bonne base pour comprendre le SDN :Le SDN découple le système qui prend les décisions sur la direction vers laquelle le trafic est envoyé (le control plane : plan de contrôle) des systèmes sous-jacents qui expédient le trafic vers leurs destinations (le data plane : plan des données). Les inventeurs et les fournisseurs de ces systèmes affirment que cela simplifie le réseau. Via le contrôleur, les administrateurs de réseaux peuvent facilement et rapidement prendre et faire avancer les décisions sur la façon dont les systèmes sous-jacents (switches, routeurs) du plan de transfert vont gérer le trafic.

Le SDN a besoin d'une méthode pour faire communiquer le plan de contrôle avec le plan de données. L'un de ces mécanismes est l'OpenFlow, souvent considéré comme équivalent du SDN, mais d'autres mécanismes conviennent également.

En séparant le plan de contrôle des plans de transfert, les data centers peuvent réduire les coûts et gagner en agilité. Qui pourrait être contre ? Comment y parvient-on ?

1. En réduisant le niveau de dépendance sur les réseaux sur mesure bâtis sur des ASIC coûteux et conçus sur le modèle pay-as-you-grow (croissance à la carte) qui se transforme souvent en excédents de capacités coûteux. En d'autres termes, vous pouvez tirer davantage parti de votre réseau.

2. Les SDN fournissent une meilleure programmabilité, permettant de faire évoluer plus facilement les réseaux ainsi que la conception et l'administration du système.

3. Agilité et flexibilité. Tout le monde en a besoin, tout le monde les réclame, le SDN les procure. Le SDN permet aux entreprises de déployer plus rapidement une nouvelle infrastructure, des applications et des services qu'on ne le ferait avec un réseau traditionnel.

OpenFlow

Souvent, on utilise OpenFlow et le SDN de manière interchangeable, mais ce n'est pas la même chose. OpenFlow n'est qu'un élément de l'architecture SDN globale. OpenFlow est un standard ouvert pour un protocole de communication permettant d'établir une interaction entre le plan de contrôle et le plan de transfert. En tant que standard ouvert, il est régi par l'OpenFlow Consortium. OpenFlow n'est pas le seul protocole disponible ou en cours de développement pour le SDN. Le réseau open source OS, ONOS, géré par The Open Networking Lab (ON.Lab), représente une autre option.Virtualisation des fonctions du réseau (NFV)

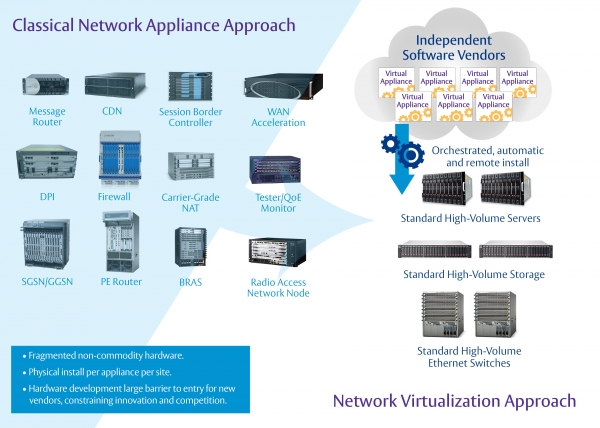

C'est un terme qui signifie plusieurs choses selon les secteurs. En ce qui nous concerne, nous nous concentrerons sur sa signification pour le marché des télécoms. Pour comprendre ce qui a conduit au développement du NVF, regardons de près comment l'industrie des télécoms déploie ses réseaux. Depuis plus de 30 ans, les télécoms s'appuient sur des systèmes sur mesure, certains développés avec leurs propres ASIC (comme Cisco, F5 ou Juniper) et des systèmes d'exploitation propriétaires (Cisco IOS par exemple), et cette technologie est ensuite intégrée dans les stations de base, les routeurs et les commutateurs Ethernet, tous optimisés pour un usage bien spécifique. La nature propriétaire de tout cela se traduit en systèmes très onéreux et en cycles de développement lents.Grâce à l'initiative NFV qui est désormais le fer de lance des principaux prestataires de services télécoms, nous avons fait un pas en avant. La valeur ajoutée du NFV se trouve dans la création d'une approche à base de standards pour virtualiser les principales applications télécoms, ce qui change radicalement la façon dont les réseaux télécoms sont développés et administrés. Ce faisant, le NFV permet à ces applications de tourner sur des serveurs standards. Et, bien sûr, il en résulte de grosses économies et davantage de flexibilité.

Les avancées réalisées dans cette technologie, comme le SDN, des débits plus rapides (40Gb Ethernet) et des processeurs plus puissants ont fait que le NVF convient parfaitement à un équipement de grande série.

Le NFV peut être mis en oeuvre sans SDN, bien que les deux solutions puissent fonctionner ensemble. Le NFV est capable de prendre en charge le SDN en fournissant l'infrastructure sur laquelle le logiciel SDN peut tourner. Ces deux technologies partagent un objectif commun qui est de tourner sur des serveurs et des switchs courants du marché, plus économiques.

Le projet OpenCompute

Le projet OpenCompute est une initiative lancée par Facebook visant à construire des infrastructures informatiques éco-énergétiques, facilement évolutives et bon marché. Cette initiative est née de la conception et du développement de l'impressionnant data center Facebook de Prineville, dans l'Oregon. Avançant sur les traces du logiciel open source, les projets OpenCompute sont ouverts, partagés et disponibles pour tous. Le projet OpenCompute inclut les logiciels, les serveurs, le stockage, les réseaux et les data centers. Grâce à l'utilisation de systèmes ouverts OpenCompute, le projet OpenCompute permet au data center Facebook de Prineville de revendiquer 38 % d'efficacité supplémentaire et d'être 24% moins cher à fabriquer et à entretenir que les autres data centers équipés de composants propriétaires. Intéressant, n'est-ce pas ?Comme vous voyez, il existe des thèmes récurrents autour des technologies que nous venons d'aborder. En voici un résumé : prix bas, efficacité énergétique, non propriétaire, ouvert, évolutif, flexible et agile. Si vous ne pensiez pas reconsidérer votre data center dans l'immédiat, vous devriez quand même y penser si vous voulez rester compétitif.

Peu importe la technologie que vous choisissez, une chose est sûre, le cloud met à l'épreuve les E/S, et des goulets d'étranglement au niveau des E/S vont se produire à d'autres endroits. Plus vous vous trouvez loin du traitement, plus la latence devient un défi.

Pour faire face à une avalanche de nouvelles technologies, recherchez celles qui vont diminuer la latence, comme le RDMA over Converged Ethernet (RoCE). Recherchez aussi des solutions qui permettent une utilisation souple des ressources et qui ne vous enferment pas dans des engagements à long terme, comme avec les appareils et les infrastructures spécialisés et les logiciels propriétaires, afin de rester dans une position idéale pour tirer parti des nouvelles innovations dès leur arrivée sur le marché. Et maintenant, accrochez vos ceintures, préparez-vous à décoller !

1. Open Networking Foundation: "Software-Defined Networking: The New Norm for Networksm" April 13, 2012. Retrieved August 22, 2013.