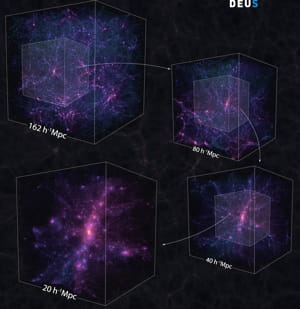

Deus : un projet Big Data géant pour décrypter l'univers Des volumes de données impliquant une optimisation des entrées et sorties

Pour optimiser encore les flux d'entrées et sorties (I/O), l'Observatoire de Paris et le GENCI ont fait appel à une autre technique : actionner immédiatement les analyses post-traitements (sélection des objets simulés à conserver en fonction de critères, reconstruction de la distribution de matière en tenant compte de l'espace et du temps...).

Des post-traitements exécutés en même temps pour optimiser les I/O

"Autant profiter que les données étaient toutes en mémoire pour faire ces post-traitements. Relire 150 Po aurait en effet nécessité de relancer un traitement sur toute la machine, ce qui aurait été impossible vue le temps nécessaire, notamment pour les I/O", explique Stéphane Requena. Au final, les données brutes générées ont été finalement réduites à 1.5 Poctets. Quant au temps des entrées et sorties, il représentait encore 40% du temps global de la simulation.

Optimisation des I/O et du parallélisme : conditions de la réussite

"Quand vous atteignez un tel volume de données à traiter, l'expertise sur le Big Data dépasse donc les savoir-faire en matière de structuration des données et d'algorithmes de calcul. D'autres aspects entrent en jeu, comme les I/O et le parallélisme, qui conditionnent la réussite du projet", résume Jean-Michel Alimi, avant d'évoquer la délicate question de la gestion de la mémoire et de sa répartition. "Certaines grilles de la simulation, représentant l'évolution des particules dans l'espace, pouvaient nécessiter beaucoup plus de mémoire que d'autres, notamment les plus lâches d'entre elles. Pour éviter les swap, nous avons donc dû travailler sur des cas particuliers et entrer au 'chausse pied dans la machine' en définissant des schémas de communication adaptés à ces besoins particuliers."

Dans l'optique de gérer la montée en charge du traitement à 555 milliards de particules, l'Observatoire a dû, enfin, effectuer en amont un gros travail d'optimisation des algorithmes de calcul.