Dans son livre blanc, Google consacre un chapitre complet au fichier d'exclusion

des robots. Placé à la racine du site, ce fichier texte est pris en compte

par la majorité des moteurs de recherche. Il indique aux moteurs les éléments

devant être exclus du crawl.

Exemple de fichier d'exclusion des robots donné par Google, si un webmaster

souhaite empêcher l'indexation de ses logs internes :

User-Agent: Googlebot - cette mention précise que la section

qui suit contient toutes les instructions destinées au robot de Google.

Disallow: /logs/ - En précisant "Disallow" (non

admis en français), on interdit au robot de Google l'accès

aux fichiers.

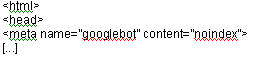

Alternative au robots.txt : les méta-tags. Exemple d'un webmaster souhaitant

exclure des nouveaux articles, accessibles uniquement pour les abonnés du

site.

La mention 'noindex' dans le meta-tag stoppe les robots qui n'iront pas

copier les informations dans son index.

Pour ne pas avoir de page en cache conservée par le moteur, il suffit de la même

manière de le préciser dans les méta-tags la mention 'noarchive'

"En général, le fichier robots.txt est une bonne solution pour fournir une

échelle de contrôle sur le site, alors que les méta-tags permettent un contrôle

plus affiné sur les fichiers individuels ", explique Google dans son livre blanc.

|

|

Tableau récapitulatif des

robots de Google |

|

| |

Googlebot |

indexe les pages Web pour son moteur classique et actualité |

|

| |

Googlebot-Mobile |

indexe les pages Web pour son moteur mobile |

|

| |

Googlebot-Image |

indexe les pages Web pour son moteur images |

|

| |

Mediapartners-Google |

indexe les pages Web pour déterminer le contenu AdSense

(pour les sites affiliés AdSense) |

|

| |

Adsbot-Google |

contrôle la qualité des pages d'atterrissage (Landing

page) proposées par les annonceurs d'AdWords |

|

|

|

Source : "Making the Most of

Your Content", Google |

|