Devstral 2 et Devstral Small 2 : l'IA on-device de Mistral tient-elle ses promesses ?

Mistral de retour dans la course à l’IA ? Dévoilés début décembre, Devstral 2 et sa déclinaison on-device, Devstral Small 2, marquent une avancée notable dans l’IA open source spécialisée en génération de code, un domaine encore largement dominé par les grands laboratoires chinois jusque-là. Mais au-delà des benchmarks flatteurs, une question demeure : peut-on vraiment utiliser le nouveau modèle de Mistral pour coder localement sur son PC ? Nous l’avons mis à l’épreuve.

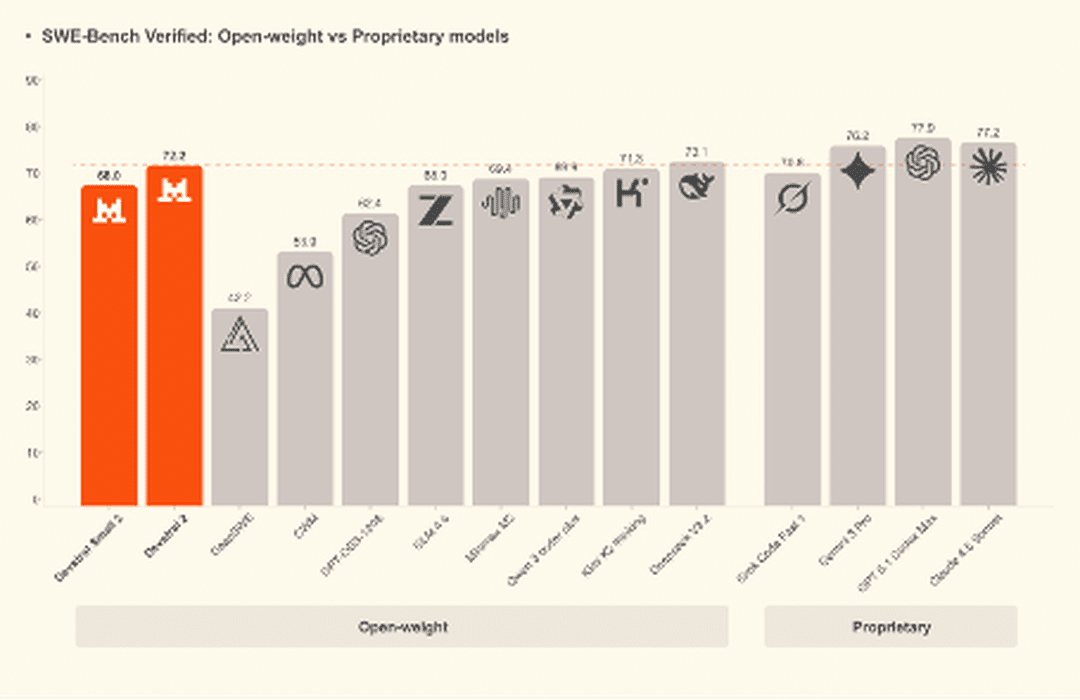

Des scores excellents sur SWE-bench Verified

C’est le principal atout du nouveau modèle de code de Mistral. Devstral 2 affiche une performance de pointe sur SWE-bench Verified, la référence actuelle pour évaluer la capacité des LLM à résoudre de façon autonome des problèmes de code réels et reproductibles. Le modèle atteint ainsi 72,2%, dépassant Kimi K2 Thinking, une référence de l’écosystème open source, et se plaçant au niveau de DeepSeek V3.2. L’écart avec la référence du moment, Claude Opus 4.5, n’est que de 8,7 points, alors même que Devstral 2 ne compte “que” 123 milliards de paramètres, contre plusieurs centaines de milliards (estimés) pour le modèle d’OpenAI.

Mais la vraie rupture intervient avec Devstral Small 2. Mistral a anticipé l’appétence des développeurs pour des modèles réellement exploitables en local et dévoile une variante allégée, inférable sur un seul GPU. Avec seulement 24 milliards de paramètres, Devstral Small 2 atteint 68% sur SWE-bench Verified, n’accusant qu’un écart de 3 points avec Kimi K2 Thinking malgré une taille 41 fois inférieure. Pour la communauté, c’est une avancée majeure : un modèle on-device offrant des performances jusqu’ici réservées à des architectures nettement plus lourdes.

Attention toutefois, les développeurs ne pourront pas reproduire à l’identique les performances brutes annoncées. Avec 24 milliards de paramètres, même les configurations récentes (M4 notamment) exigeront l’usage d’une version quantisée pour obtenir une exécution fluide. Malgré cela, les performances resteront largement supérieures à celles des modèles de taille équivalente actuellement disponibles sur le marché.

L’autre rupture : le prix

|

Modèle |

Input (1M tokens) |

Output (1M tokens) |

|---|---|---|

|

Devstral Small 2 |

0,10 $ |

0,30 $ |

|

Devstral 2 |

0,40 $ |

2 $ |

|

Gemini 3 Pro (Contexte ≤ 200k) |

2 $ |

12 $ |

|

Gemini 3 Pro (Contexte > 200k) |

4 $ |

18 $ |

|

Opus 4.5 |

5 $ |

25 $ |

|

GPT-5.1-codex-max |

1,25 $ |

10 $ |

C’est l’autre point fort de Devstral 2, le prix. Grâce à ses efforts sur la taille du modèle, Mistral est capable de proposer un modèle de code vraiment abordable pour les développeurs. Même s’il ne surperforme pas GPT-5.1-codex-max (la star d’OpenAI pour le code), Devstral 2 est environ trois fois moins cher en input et cinq fois moins cher en output. Si on le compare à Claude Opus 4.5, le modèle est alors 12,5 fois moins cher, aussi bien en input qu'en sortie.

Autre option stratégique : l’inférence sur infrastructure. Devstral 2, bien que relativement compact au regard de ses performances, est dimensionné pour fonctionner sur quatre GPU H100 ou une capacité de calcul équivalente. L’investissement reste conséquent, mais il devient pertinent pour des entreprises de taille intermédiaire cherchant à maîtriser leurs coûts et leur souveraineté. Enfin, le véritable bon plan pour les développeurs indépendants et les structures modestes reste Devstral Small 2. Pensé pour tourner sur un seul GPU, il peut même fonctionner sur CPU dans ses versions les plus quantifiées, mais il ne faudra clairement pas en attendre de miracle.

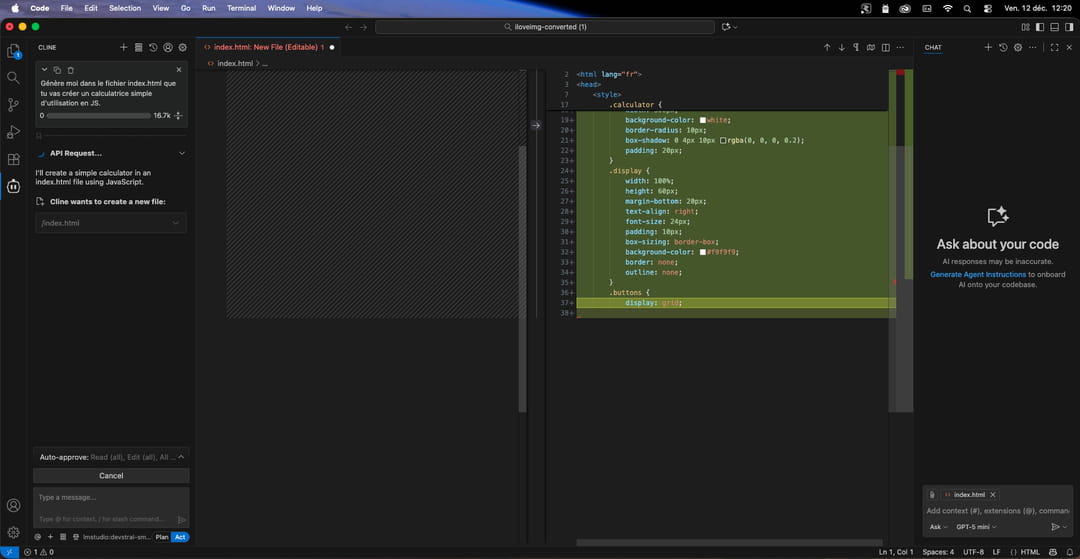

Que vaut Devstral Small 2 avec Cline ?

Pour évaluer les performances de Devstral Small 2 sur notre machine, un Mac mini équipé d’une puce M4 et de 24 Go de RAM, nous avons recours à une inférence locale via LM Studio, connecté à Cline dans VS Code. Le modèle utilisé est une version quantifiée en 4 bits (devstral-small-2:24b-instruct-2512-q4_K_M), que nous téléchargeons directement depuis la bibliothèque de LM Studio. Dans cette configuration, le modèle requiert environ 15 à 20 Go de mémoire vive pour être inféré de manière fluide et stable sur une machine grand public.

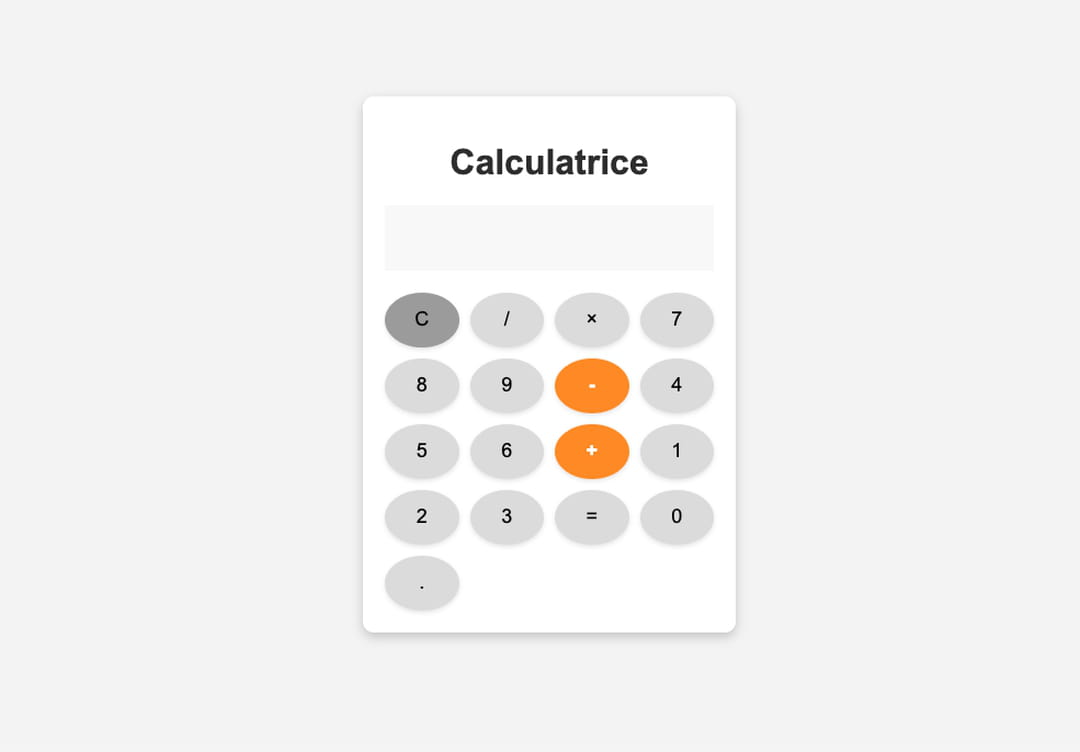

Nous demandons au modèle de concevoir une calculatrice minimaliste en JavaScript, intégrée dans une page web et sans dépendances lourdes. Devstral Small 2 s’exécute alors sans difficulté particulière. L’ensemble reste toutefois sensiblement plus lent que ce à quoi on peut être habitué avec Claude Code : il faut compter environ 3 à 5 minutes pour générer une centaine de lignes de code. Une cadence qui demeure néanmoins supérieure à celle d’un développement manuel. Le code produit est propre, fonctionnel, et la calculatrice affiche un design soigné, très proche de l’esthétique d’une calculatrice d’iPhone. Devstral 2 impressionne également par sa robustesse opérationnelle : là où de nombreux modèles, y compris de plus grande taille, multiplient les erreurs de tool calling en local, le modèle de Mistral n’en génère aucune sur l’ensemble de notre séquence de développement. C’est notable.

La seule véritable limite est la taille de contexte. Bien que Devstral Small 2 dispose théoriquement d’un contexte maximal de 256 000 tokens, nous avons volontairement limité la fenêtre à 16 000 tokens lors de l’inférence afin d’éviter une saturation de la ram de notre machine. Une telle contrainte réduit fortement les usages possibles : elle ne permet ni de travailler confortablement sur des projets de longue durée, ni de manipuler des bases de code de taille moyenne. En pratique, Devstral Small 2 doit donc, pour un usage quotidien, être inféré sur une machine disposant d’une quantité de RAM nettement plus élevée, idéalement entre 32 et 64 Go pour travailler sereinement. A défaut, le modèle conserve un intérêt ponctuel : édition rapide de code, génération à la volée ou assistance hors ligne, notamment lorsque la connexion internet n’est pas disponible.

Mistral Small 2 et surtout Devstral 2 constituent de véritables avancées pour les développeurs qui souhaitent s’affranchir des solutions propriétaires telles que Claude Code, Gemini CLI, Kiro ou Codex CLI, que ce soit pour des raisons de coût ou de souveraineté. Pour un usage quotidien, nous recommandons Devstral 2, qui se positionne clairement dans le haut du panier des agents de code open source actuels. Devstral Small 2, de son côté, trouve toute sa pertinence dans des contextes plus ponctuels : déplacements, environnements à connectivité limitée ou besoins d’édition rapide hors ligne. Selon nous, cette combinaison représente aujourd’hui la configuration la plus équilibrée pour coder efficacement avec l’IA, à moindre coût et sans dépendance à des géants américains.