Google AI Edge Gallery : une IA sur votre smartphone 100% confidentielle

Les promesses de l'IA locale commencent à se concrétiser. Grâce à l'optimisation des éditeurs de modèle, il devient désormais possible d'utiliser l'IA générative en local sur son propre téléphone. Avec seulement quelques gigaoctets de ram, les derniers smartphones Android peuvent inférer (exécuter) des modèles d'un à quelques milliards de paramètres. Google, qui a récemment présenté une famille de SLM adaptée aux mobiles, propose maintenant une application mobile dédiée pour interroger ses modèles en local : AI Edge Gallery.

Une application basée sur Gemma 3n

AI Edge Gallery utilise les modèles Gemma 3n et Gemma 3 (1B) développés par DeepMind. Grâce à des optimisations logicielles, malgré ses 5 à 8 milliards de paramètres totaux, Gemma 3n ne consomme que 2 à 3 Go de mémoire. Des performances d'autant plus remarquables que les benchmarks placent le modèle dans le haut du panier pour les modèles de taille équivalente. Sur la Text Arena (lmarena), le modèle est supérieur dans le classement à Claude 3.5 Haiku ou Amazon Nova. Plus intéressant encore, Gemma 3n accepte en entrée texte, images, vidéo et audio.

L'application est pour l'heure disponible uniquement sur Android, via le Play Store ou en téléchargeant le fichier APK directement depuis le repository GitHub. Pour utiliser l'application il faudra obligatoirement disposer d'Android 12 ou d'une version supérieure. L'app permet principalement d'interroger des éléments visuels, de transcrire et d'analyser des fichiers audio, d'utiliser un document en source ou simplement de dialoguer avec l'IA en utilisant du texte. Un minimum de 4 à 6 Go de ram est nécessaire, et un espace de 0,5 à 4,7 Go selon le modèle que vous choisissez.

Comment utiliser Gemma 3n sur AI Edge Gallery ?

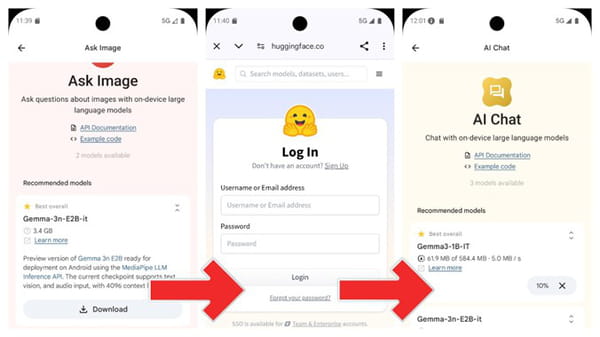

Une fois l'application téléchargée, à la première ouverture, AI Edge Gallery nécessite de télécharger les modèles Gemma. Ils ne sont pas intégrés nativement. L'application supporte, en septembre 2025, trois modèles : Gemma3-1B-IT (550 MB environ), pour la partie textuelle uniquement et Gemma-3n-E2B-it (3,4 GB) et Gemma-3n-E4B-it (4.7 GB) pour analyser des images ou des fichiers audio. Le téléchargement des poids du modèle se fait depuis Hugging Face. Il faudra vous identifier sur Hugging Face (ou créer un compte). Ensuite, vous devrez accepter les conditions d'utilisation des modèles Gemma, toujours sur Hugging Face. Une fois le formulaire complété, le téléchargement débute automatiquement dans l'application.

Chat, analyse d'image, analyse de fichier audio…

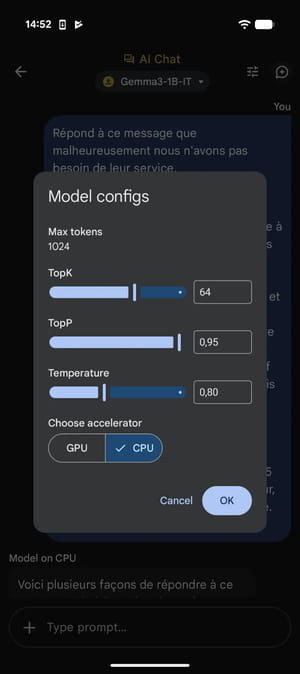

Une fois le modèle téléchargé, il est possible de l'utiliser directement en mode chat, pour l'analyse d'image ou de fichier audio. Dans le cadre de ce test nous utilisons un Google Pixel 10 (avec 12 Go de ram). AI Edge Gallery permet de configurer le TopK, le TopP, la Temperature, et la puce d'inférence (CPU ou GPU). Pour ce test, nous utiliserons les valeurs par défaut du TopK et TopP et une temperature de 0,8. Enfin, selon nos tests sur Pixel, l'inférence sur CPU est plus rapide.

Gemma-3n-E2B-it plus précis que Gemma3-1B-IT

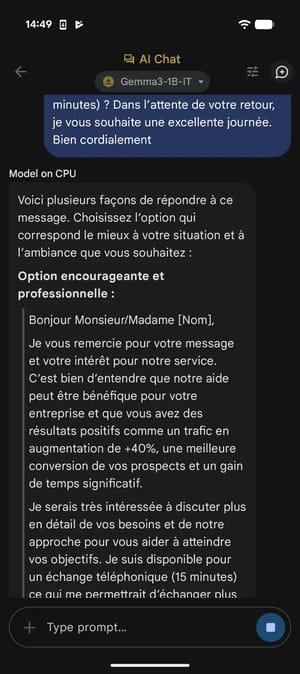

L'IA peut, par exemple, être très utile pour répondre à un SMS ou à un email en toute confidentialité. Nous demandons par exemple à Gemma-3n-E2B-it de répondre à un mail.

Gemma-3n-E2B-it répond assez rapidement (environ 144 tokens par seconde) mais le téléphone a toutefois tendance à chauffer. La réponse proposée par l'IA à notre email est plutôt correcte même si l'on observe de meilleurs résultats avec des prompts en anglais. Le modèle, par sa taille restreinte, est sans aucun doute meilleur dans la langue de Shakespeare. Pour obtenir de meilleurs résultats, il est préférable d'utiliser Gemma-3n-E2B-it, doté de plus de paramètres. La latence de réponse est plus longue mais le résultat n'en est que meilleur.

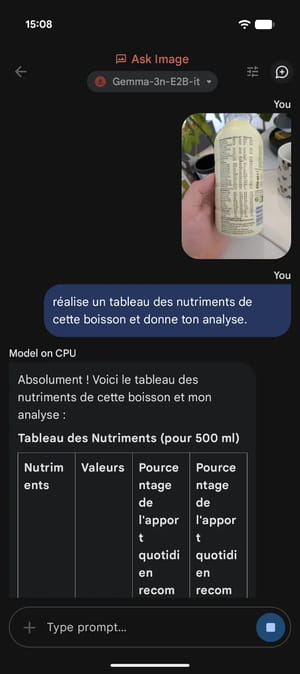

L'analyse d'image on-device

Plus utile encore, AI Edge Gallery permet d'analyser des images à la volée. L'analyse visuelle ne sera pas aussi précise qu'avec un LLM mais les résultats sont là. OCR, description, analyse de graph…

Nous demandons par exemple à Gemma-3n-E2B-it d'analyser les nutriments présents dans une boisson à partir d'une photographie. L'IA propose un résultat cohérent en moins d'une minute. La génération est légèrement plus lente mais ne dégrade pas excessivement l'expérience.

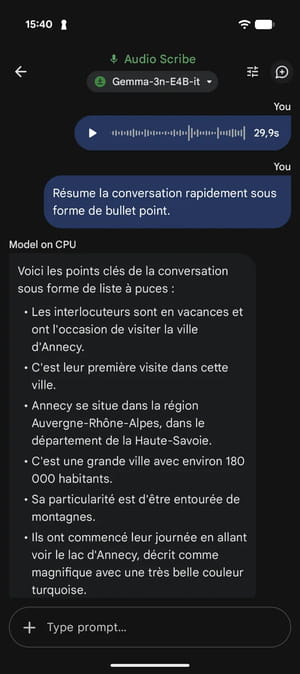

Transcrire ou résumer un fichier audio

C'est un cas d'usage qui n'aurait pas été possible il y a encore quelques années. AI Edge Gallery permet de traiter, avec un SLM, n'importe quel fichier audio. Une seule limite : la longueur. Par défaut, l'application ne permet de traiter des fichiers audio que d'une durée de 30 secondes. Vraisemblablement, la taille de contexte du modèle doit être limitée pour éviter de saturer la mémoire du téléphone.

Nous demandons par exemple à l'IA de résumer rapidement sous forme de bullet point une note vocale. Le résultat est là, la consigne est parfaitement respectée. On regrette simplement les limites de longueur imposées.

Les promesses de l'IA on device sont respectées

AI Edge Gallery est une application particulièrement utile, que ce soit pour tester les capacités de l'IA on device sur son smartphone ou pour utiliser l'IA générative en totale sécurité. L'approche on device prend tout son sens dans les situations où la confidentialité est vitale ou dans les environnements sans connectivité (avions, souterrains, zones blanches). Les données restent sur l'appareil.

Malgré quelques limitations (durée audio restreinte, performances variables selon la langue, latence) l'application est globalement très prometteuse. D'autant plus quand on sait qu'AI Edge Gallery a été initialement conçue pour "inspirer et permettre aux développeurs de créer des expériences alimentées par des modèles d'IA on device" et non pas pour une utilisation grand public.