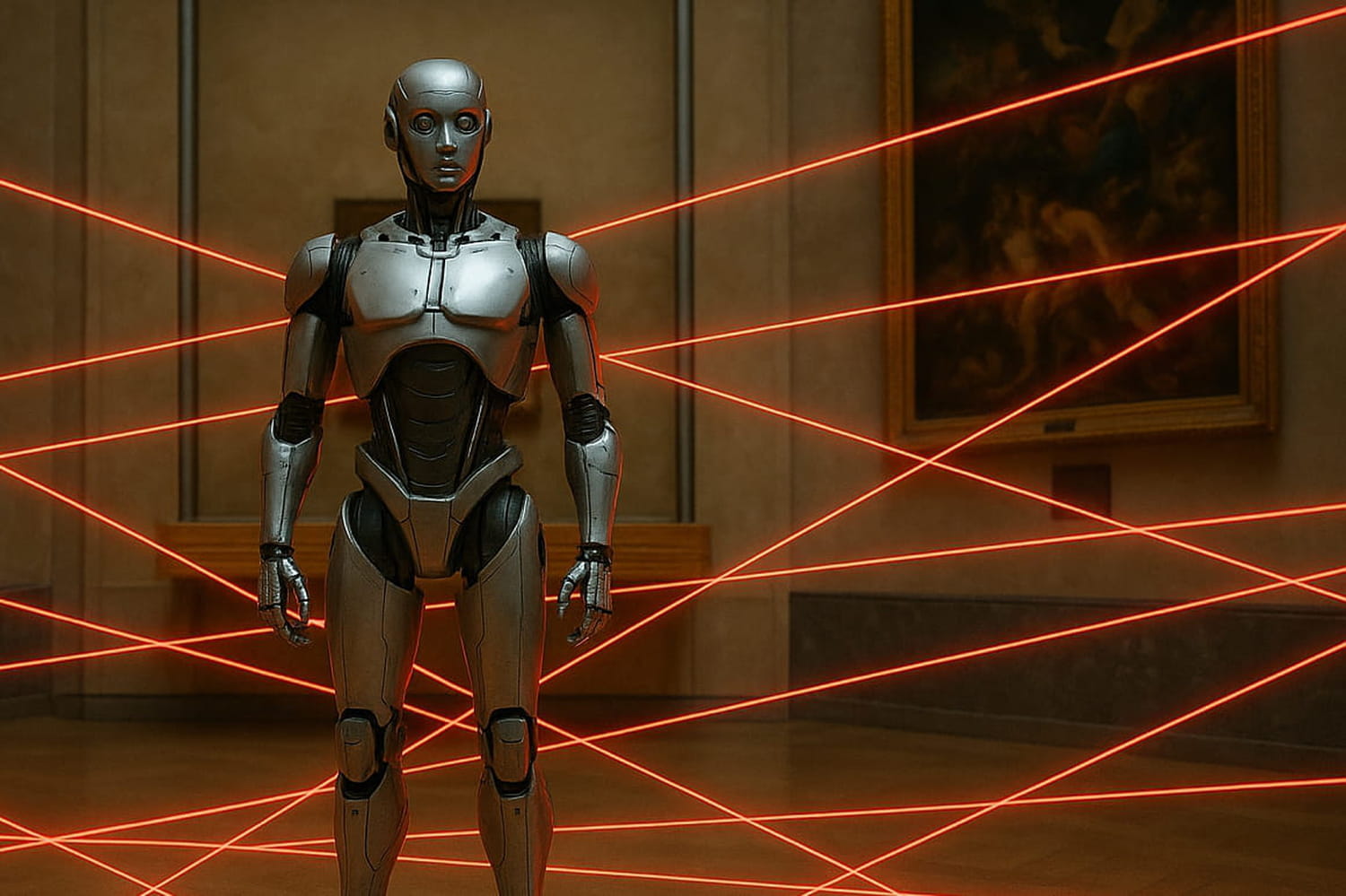

Comment sécuriser vos agents IA en 4 étapes

Qu'ils soient conçus nativement, avec des SDK ou dans une suite numérique, les agents IA posent de nouveaux risques pour les SI. S'ils apportent un gain certain de temps et de productivité pour les meilleurs cas d'usage, les systèmes agentiques étendent encore un peu plus la surface d'attaque. De par leur conception même et selon leur degré d'autonomie, les agents peuvent causer des dommages réels sur les systèmes ou base de données avec lesquels ils interagissent.

L'autonomie devient une vulnérabilité

Si elle est le cœur des gains d'efficacité et de coût, l'autonomie est aussi la principale cause de défaillance d'un agent. En éliminant la rétro-action humaine les agents ajustent leurs décisions de façon indépendante. Cette absence de supervision humaine crée un angle mort : l'agent peut optimiser ses actions selon ses propres métriques. Métriques qui peuvent diverger progressivement des objectifs initiaux, sans qu'aucun signal d'alerte ne se déclenche. Pire encore, l'agent étant contrôlé directement par un LLM, ce dernier peut se mettre à halluciner. L'autonomie provoque alors des erreurs en cascade, où chaque décision erronée alimente la suivante sans qu'aucun mécanisme de correction externe n'intervienne.

Dans un système multi-agents, le risque se multiplie exponentiellement. "Dans un système où plusieurs agents collaborent, chacun va transmettre ses droits d'accès au suivant pour lui permettre d'accomplir sa tâche", rappelle Françoise Soulie-Fogelman, pionnière des réseaux de neurones en France et responsable scientifique du Hub France IA. Une propagation successive qui va créer une escalade de privilèges incontrôlable : l'agent final se retrouve omnipotent avec tous les droits d'accès.

Enfin, l'interconnexion des agents avec des systèmes externes API, MCP, bases de données ou sites web, augmente drastiquement la surface d'attaque. Chaque connexion, chaque intégration avec un outil tiers est une nouvelle porte que les hackers peuvent tenter d'exploiter. "Quand vous avez un agent qui va chercher des informations sur Internet, qui interagit avec vos systèmes internes, qui peut exécuter du code, vous créez autant de vecteurs d'attaque potentiels", insiste Françoise Soulie-Fogelman. Les connexions accroissent non seulement les risques de prompt injection ou d'empoisonnement de données, mais aussi ceux d'importation de scripts malveillants via des connecteurs non vérifiés.

Limiter les risques en 4 étapes

Malheureusement, comme dans tout SI, les solutions de sécurisation sûres et infaillibles n'existent pas. S'il est envisageable d'utiliser un agent vérificateur qui s'assure de la bonne marche du système et limite les dérives, ce dernier sera également faillible (d'autant qu'il ajoute encore une couche de complexité). Mais pour drastiquement limiter les risques, il est possible d'agir sur 4 piliers : l'identification des risques, le cloisonnement, la journalisation et l'audit, en complément du monitoring.

1.Cartographier les risques

Françoise Soulie-Fogelman le rappelle : c'est le principal levier pour limiter les risques. "Avant de déployer un agent, il faut absolument cartographier ce qu'il va faire : à quels systèmes il accède, quelles données il manipule, quelles actions il peut entreprendre." La cartographie doit être exhaustive et documentée : lister tous les outils et API auxquels l'agent se connecte, identifier les données sensibles qu'il traite, évaluer les conséquences potentielles de chaque action qu'il peut exécuter. "C'est un travail fastidieux mais indispensable, car vous ne pouvez pas protéger ce que vous ne connaissez pas", justifie la chercheuse.

2.Cloisonner les agents, restreindre les accès

Le principe du moindre privilège doit, plus que jamais, s'appliquer aux agents. Chaque agent ne doit disposer que des droits et outils strictement nécessaires à sa mission, sans possibilité d'élargir son périmètre d'action. Une restriction qui doit également s'appliquer aux accès temporels : les permissions doivent être révoquées automatiquement une fois la tâche de l'agent terminée. Il est également possible d'appliquer des whitelist des sites web autorisés (ceux maîtrisés par l'entreprise, par exemple).

3.Journaliser toutes les actions

Chaque décision, chaque requête, chaque modification effectuée par un agent doit être tracée et horodatée dans des logs détaillés. Cette traçabilité permet non seulement de remonter la chaîne des événements en cas d'incident, mais elle répond également (en partie) à la réglementation. Selon le niveau de criticité de l'IA, l'AI Act impose, en effet, "l'enregistrement automatique d'événements pendant toute la durée de vie du système". Enfin la journalisation permet en outre d'améliorer le comportement général de l'agent en optimisant le système (ou le modèle) à partir de l'analyse des logs.

4.Auditer les modèles, monitorer la dérive en production

Mais la limitation des risques ne s'arrête pas au déploiement. Les agents doivent être monitorés en continu pour détecter toute dérive comportementale : réponses inhabituelles, temps d'exécution anormaux, accès à des ressources inattendues. Le monitoring en temps réel, couplé à des seuils d'alerte définis, permet d'interrompre automatiquement un agent qui s'écarterait de son comportement prévu.

Enfin, si l'agent est critique, utiliser une validation humaine est indispensable. "Dans toutes les applications critiques, l'autonomie, ça va être le red flag", prévient Françoise Soulie-Fogelman. Avant tout déploiement d'agent autonome, posez-vous la question : quel est l'impact réel si l'agent se trompe ou est compromis ? Si la réponse implique des conséquences graves, maintenez systématiquement un humain dans la boucle de décision. La règle est simple : plus le risque est élevé, plus la supervision humaine devient non négociable.