Protection des mineurs : les géants de l'IA attaqués sur un nouveau front aux US

Les chatbots basés sur l'IA générative, comme ChatGPT, constituent-ils un danger pour la santé mentale des mineurs qui les utilisent ? C'est ce qu'entend déterminer la Federal Trade Commission (FTC), autorité américaine chargée de l'application du droit à la consommation et des pratiques concurrentielles.

L'agence a pour cela demandé aux géants de la tech qui opèrent de tels chatbots, dont OpenAI, Meta ou encore Character.AI, de lui transmettre des documents internes qui lui permettront d'évaluer les risques et de planifier de futures actions en conséquence.

Suicide de plusieurs jeunes utilisateurs

Les autorités américaines sont sous la pression d'organisations parentales et de groupes de défense des mineurs qui demandent un meilleur encadrement de ces chatbots pour protéger les plus jeunes. Ces pressions font notamment suite à plusieurs affaires médiatisées impliquant des jeunes s'étant suicidés après avoir noué de très fortes relations amicales, voire amoureuses, avec leur chatbot. L'an passé, un jeune Américain de 14 ans s'est par exemple donné la mort après être entré dans une relation obsessionnelle avec un chatbot de Character.AI modelé sur la personnalité de Daenerys Targaryen, un personnage de la série télévisée Game of Thrones. Character.AI permet en effet à l'utilisateur de concevoir des chatbots basés sur une personnalité fictive ou réelle. La famille du jeune homme a intenté un procès à la start-up, estimant que le chatbot a amplifié la dépression de celui-ci et l'a poussé au suicide.

Plusieurs politiques américains, de droite comme de gauche, se sont également emparés du sujet. Rebecca Bauer-Kahan, une élue démocrate de Californie, a demandé fin août un encadrement plus étroit des pratiques des sociétés d'IA après le suicide dans le Golden State d'un jeune de 16 ans devenu accro à son chatbot. Josh Hawley, sénateur du Missouri incarnant l'aile populiste du Parti républicain, et Marsha Blackburn, élue républicaine du Tennessee, ont de leur côté lancé une enquête contre Meta après que des documents internes de l'entreprise ont révélé au mois d'août qu'elle autorisait ses chatbots à avoir des conversations amoureuses avec des enfants.

Meta a répondu aux critiques en niant toutes conversations de nature érotique entre son chatbot et des utilisateurs mineurs, et en mettant en place une batterie de nouvelles règles interdisant à l'IA d'aborder un certain nombre de sujets avec ces derniers, dont le suicide, l'automutilation et les troubles de l'alimentation. OpenAI a également annoncé travailler sur ses modèles pour mieux leur apprendre à reconnaître les signes de fragilité mentale et émotionnelle chez ses utilisateurs, et à y répondre de manière adéquate.

Les risques posés par l'IA sont également une cause dans laquelle s'est impliquée la Première Dame, Melania Trump, qui en début d'année a aidé au passage d'une loi contre les hypertrucages.

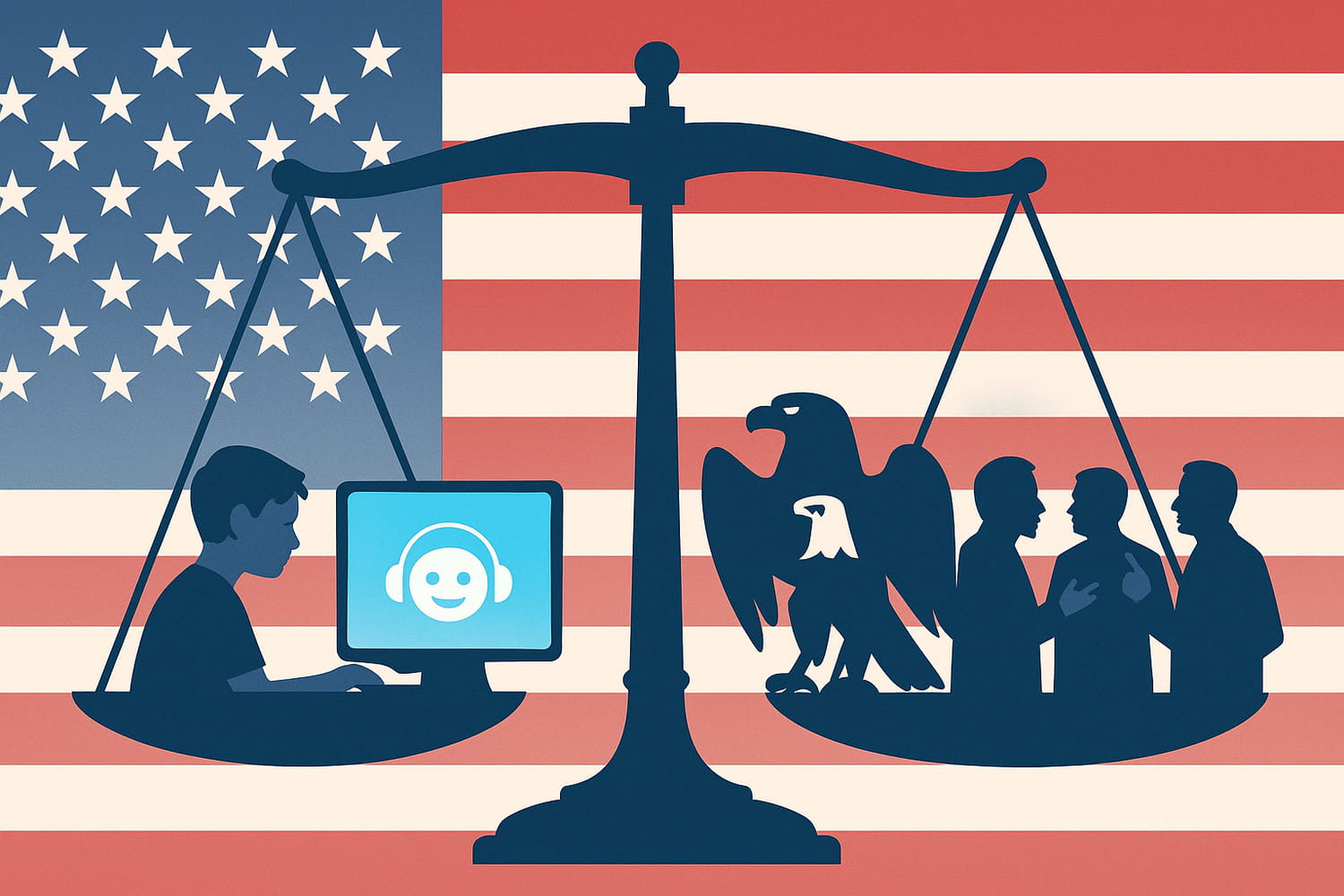

Dans un paysage politique américain très conflictuel, la protection des mineurs contre les dérives des big tech est l'un des rares sujets qui transcende les clivages en politique. En juillet, le Sénat a ainsi voté avec une large majorité le Kids Online Safety Act, une loi visant à mieux protéger les jeunes sur les réseaux sociaux, promue par Marsha Blackburn et le sénateur démocrate du Connecticut Richard Blumenthal. La loi doit désormais être votée par la Chambre des Représentants pour terminer son parcours législatif et être signée par le président.

Trump contre l'IA "woke"

Si elle transcende les clivages politiques, la volonté de mieux encadrer l'IA n'est en revanche pas partagée par toute l'administration Trump. Celle-ci comprend en effet aussi une branche libertarienne, proche de la Silicon Valley, qui voit dans les tentatives d'imposer des garde-fous à la technologie le risque de freiner les progrès de celle-ci, au bénéfice de rivaux géopolitiques des Etats-Unis comme la Chine, qui progresse à pas de géant dans ce domaine. Ce discours touche une corde sensible chez le président et a déjà donné lieu à plusieurs dérégulations favorables aux entreprises d'IA.

Au début de son second mandat, le président a ainsi annulé un décret signé par Joe Biden qui fixait certains standards en matière de sécurité à respecter pour les grands modèles d'IA et prévoyait la rédaction d'un rapport évaluant les risques posés par l'IA sur les utilisateurs américains et le marché du travail. De manière hautement symbolique, l'administration Trump a également renommé l'AI Safety Institute, lancé en 2023 par Joe Biden pour encadrer la façon dont les pouvoirs publics peuvent et doivent utiliser l'IA. Il se nomme désormais le Center for AI Standards and Innovation, et sa mission a été recentrée sur l'impératif "d'assurer la domination américaine sur l'IA". Donald Trump a par ailleurs signé un décret visant à promouvoir l'usage de l'IA dans la sphère éducative.

Le président, qui doit s'efforcer de satisfaire la branche technophile aussi bien que l'aile populiste de son clan, n'entend pour autant pas abandonner la régulation de l'IA, comme le montre l'enquête ouverte par la FTC. Il cherche en revanche à réorienter cette régulation de manière à faire consensus au sein de son propre camp. D'où un focus sur la protection des mineurs, un thème relativement consensuel.

A l'inverse, les volontés d'imposer une IA dépourvue de biais racistes ou sexistes via la régulation sont vigoureusement rejetées. En juin dernier, Donald Trump a signé un décret visant, selon ses propres mots, à mettre fin à "l'IA woke". Ce décret exige notamment des entreprises d'IA qui reçoivent de l'argent public qu'elles conçoivent des modèles politiques neutres et "dépourvus de dogmes idéologiques comme la Diversité, Equité et Inclusion".

Dans la pratique, ce décret concerne la plupart des géants américains de l'IA : OpenAI, Anthropic, Google, Meta et xAI ont tous décroché des contrats auprès du Pentagone, dans le cadre desquels ils touchent donc de l'argent public. La politique que mène l'administration Trump 2.0 sur l'IA est ainsi le reflet des différentes tendances, parfois très différentes, qui la composent.