Antigravity : on a testé l'IDE IA de Google

Google Antigravity n’aura pas supplanté Cursor ni Windsurf. L’environnement de développement intégré lancé par Google n’a pas connu un succès monstre depuis son lancement. Avec de gros problèmes techniques au lancement et des quotas jugés peu généreux, bien que gratuits, l’IDE peine à séduire la communauté. Faut-il lui laisser sa chance ou Antigravity est-il un projet voué à disparaître ? Pour se faire un avis objectif, le Journal du Net a tout de même décidé de testr l’outil, deux mois après sa sortie.

Le but initial : un IDE agentique

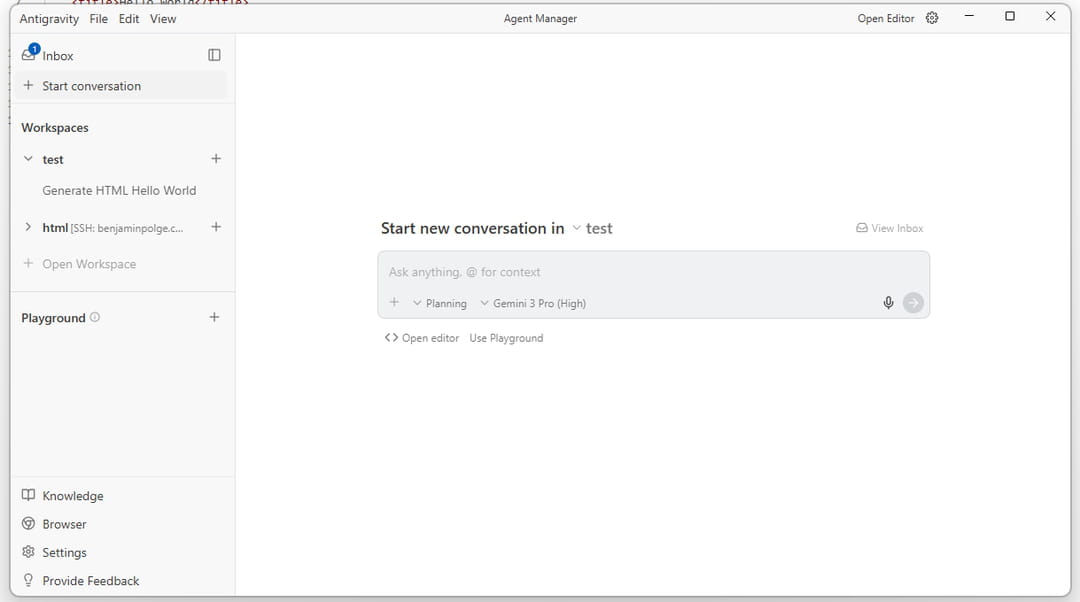

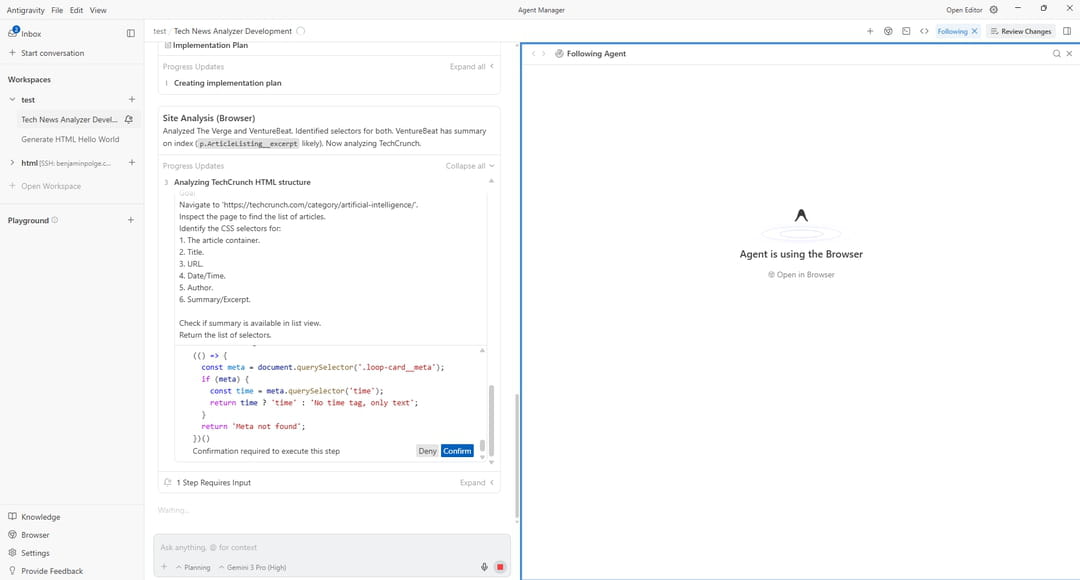

Annoncé le 18 novembre 2025 aux côtés de Gemini 3, Antigravity se voulait une rupture dans le paysage des IDE. Là où Cursor ou Copilot assistent le développeur, Google promettait une plateforme "agent-first" capable de déléguer des tâches complexes à des agents autonomes. L'architecture repose sur deux interfaces distinctes : une vue éditeur classique (fork de VS Code) pour le développement assisté, et une vue gestionnaire qui orchestre plusieurs agents en parallèle. Ces agents pilotent l'éditeur, le terminal et un Chrome embarqué pour écrire, tester et valider du code. Le pari de Google est d’avoir une IA complète capable de coder et de “voir” les interfaces et d’itérer jusqu’à obtenir le résultat escompté.

Au lancement, Antigravity ne tournait qu'avec les modèles Gemini (Pro, Flash, Deep Think). Google a ensuite ouvert l'écosystème à Claude Sonnet 4.5 et Opus 4.5, réputés pour leurs performances en code, ainsi qu'à GPT-OSS-120B d’OpenAI. L'IDE est disponible sur Windows, macOS et Linux. Google intègre aussi le Model Context Protocol (MCP).

Antigravity est utilisable gratuitement avec un compte Google personnel avec des quotas que l'éditeur qualifie de "généreux" (une terme critiqué par les retours terrain). Pour des limites plus confortables, il faut basculer sur un abonnement Google AI Pro à 19,99 dollars par mois (quotas rafraîchis toutes les cinq heures) ou Google AI Ultra à 249,99 dollars mensuels. Ces forfaits donnent accès à l'écosystème complet de Google AI : Gemini 3 Pro avec Deep Think, Flow pour la création vidéo via Veo 3.1, NotebookLM avec résumés audio, et Project Mariner. Pour les équipes, le plan Developer passe par Google Workspace AI Ultra for Business, sans grille tarifaire publique communiquée.

Le test du JDN

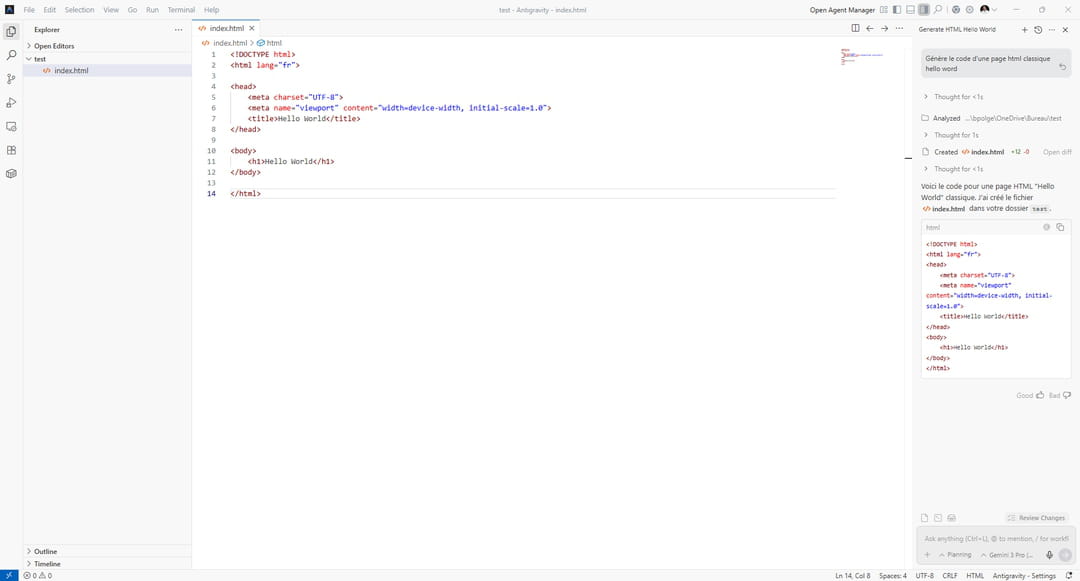

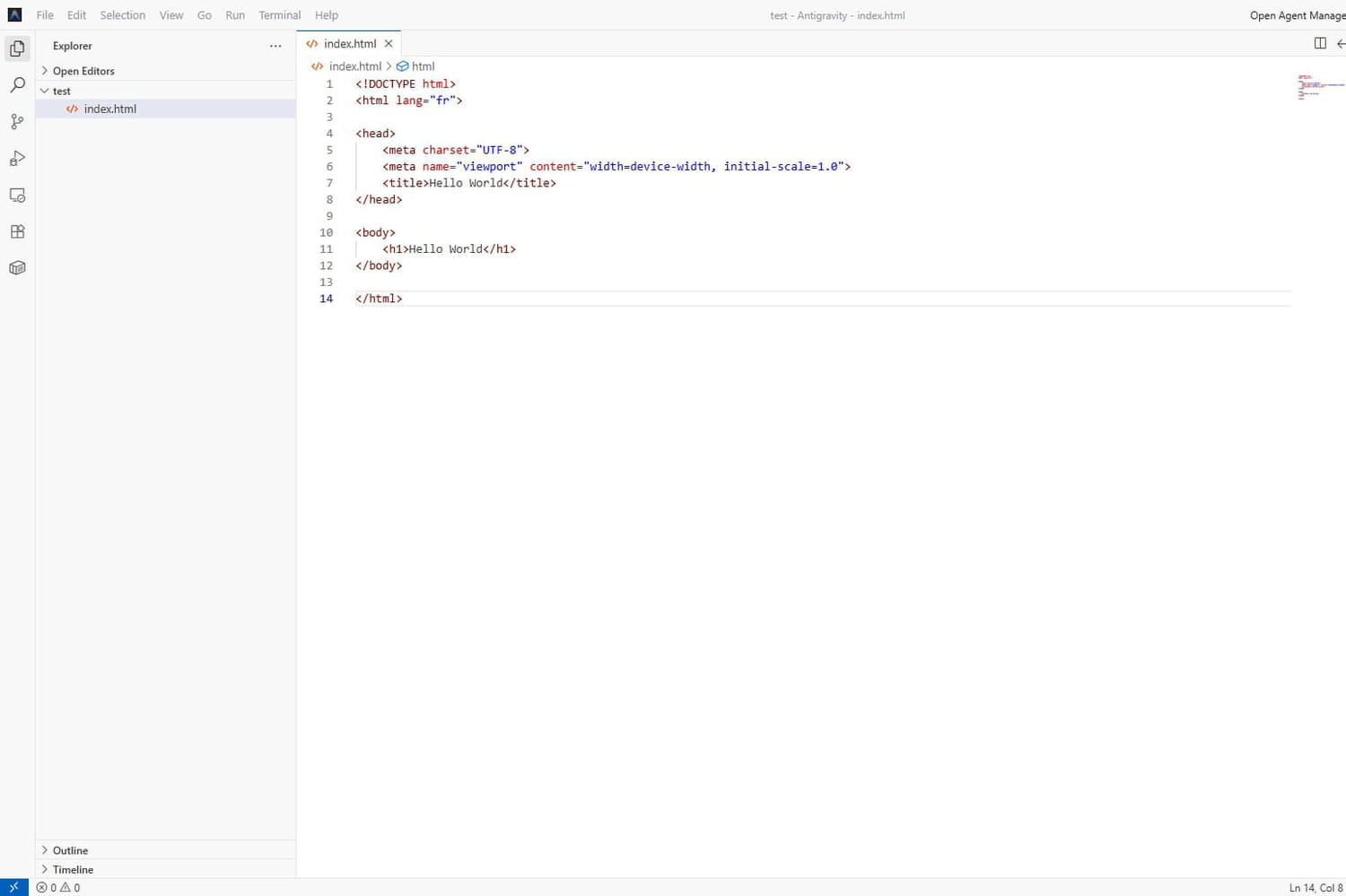

Pour ce test, nous installons Antigravity sur un appareil Windows 11. A première vue, l'application est lourde et demande au minimum 1 à 2 Go de mémoire vive, ce qui est beaucoup pour un simple IDE. De manière générale, les menus sont assez complexes et manquent d'intuitivité. On ne reconnaît pas la patte Google. Le fork a-t-il été redéveloppé trop vite ? Une fois lancé, il faut sélectionner le dossier de travail, classique. Dès que le workspace est configuré, l'éditeur se compose de deux fenêtres principales : l'éditeur, classique, et le manager, qui permet de gérer le travail des agents. Le tout est modulaire et permet aux développeurs multi-écrans d'être plus efficaces. Problème : en mobilité, il devient très complexe d'utiliser l'outil facilement sur un PC portable. Dommage.

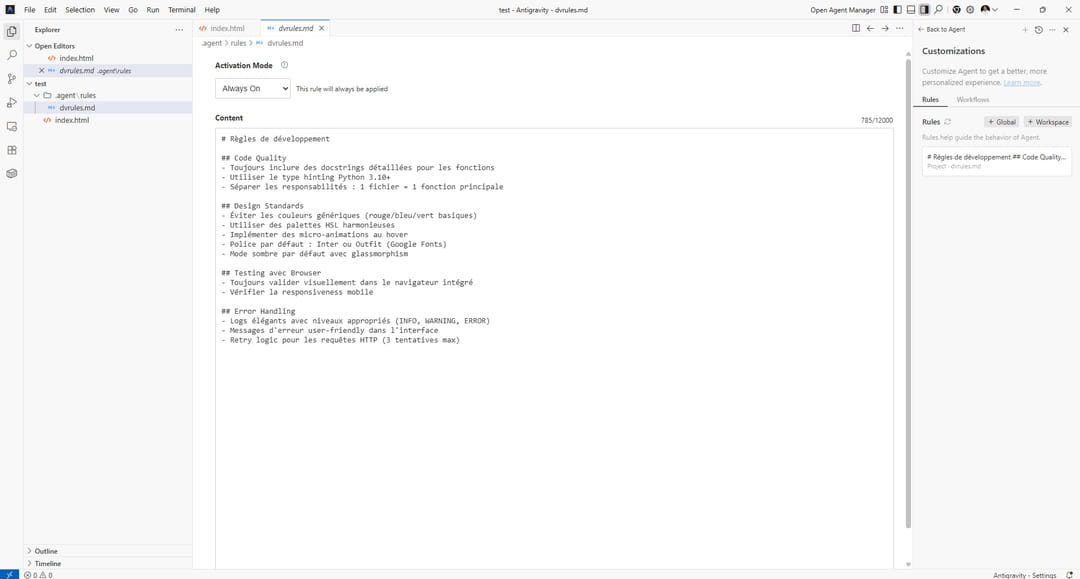

Pour le test, nous allons essayer de créer une petite application web de veille. Cette dernière devra scraper le contenu de plusieurs sites tech américains et produire un rapport sur les tendances tech du jour. Le principe : obtenir un rapport HTML interactif et assez visuel. Pour atteindre cet objectif, nous définissons des règles claires dans Google Antigravity (Customizations -> Rules -> Workspace). Le but est de guider l'IA et éviter qu'elle parte dans des complexités inutiles (voir ci-dessous).

Une fois les règles définies, nous concevons un prompt adapté à Antigravity. Nous commençons avec le mode Planning dans Agent Manager qui permet au modèle d'élaborer un plan avant de passer à l'action.

Prompt :

Je souhaite créer un outil d'agrégation et d'analyse d'actualités tech.

OBJECTIF GLOBAL :

Développer une application web complète qui scrappe automatiquement plusieurs sites d'actualités tech américains, extrait les informations clés, analyse les tendances, et génère un rapport HTML interactif et visuellement impressionnant.

SPÉCIFICATIONS TECHNIQUES :

1. ARCHITECTURE BACKEND (Python)

- Utiliser Beautiful Soup et Requests pour le scraping

- Cibler UNIQUEMENT ces 4 sources (vérifiées comme scrapables) :

* The Verge (section Tech) : https://www.theverge.com/tech

* VentureBeat (AI section) : https://venturebeat.com/category/ai/

* TechCrunch : https://techcrunch.com/category/artificial-intelligence/

* Ars Technica : https://arstechnica.com/

- IMPORTANT : Avant de scraper, utilise le navigateur intégré pour vérifier la structure HTML de chaque site et identifier les sélecteurs CSS appropriés

- Extraire pour chaque article : titre, date, résumé (150 premiers mots), URL source, auteur si disponible

- Implémenter une gestion d'erreurs robuste (timeout de 10s, gestion 404, rate limiting avec pause de 2s entre requêtes)

- Ajouter des User-Agent headers pour éviter les blocages

- Stocker temporairement les données dans un fichier JSON structuré

- Ajouter une fonction d'analyse de tendances qui identifie les mots-clés les plus fréquents (top 15)

2. GÉNÉRATION DE RAPPORT

- Créer un générateur qui transforme les données JSON en rapport HTML

- Le rapport doit inclure :

* Section "Latest News" avec les 8 derniers articles (cards avec thumbnail si disponible)

* Section "Trending Topics" avec nuage de mots-clés visuels (wordcloud style)

* Graphique de fréquence de publication par source (Chart.js - bar chart horizontal)

* Timeline des articles des dernières 48h

* Section "Top Sources" avec compteur d'articles par site

- Design PREMIUM obligatoire :

* Thème moderne avec glassmorphism sur fond gradient

* Animations au scroll (fade-in, slide-up)

* Typographie Google Fonts : Inter pour le corps, Outfit pour les titres

* Palette HSL harmonieuse : bleu électrique (#4F46E5) + violet (#7C3AED) + accents cyan

* Cards avec effet hover 3D subtil

* Micro-animations sur les boutons

3. INTERFACE WEB (HTML/CSS/JavaScript)

- Page unique responsive (mobile-first)

- Header avec logo et titre "Tech News Analyzer"

- Bouton "Analyze Now" qui déclenche le scraping

- Loader animé stylé pendant le traitement (spinner + texte)

- Affichage dynamique du rapport généré avec smooth scroll

- Mode sombre par défaut avec toggle light/dark (icône lune/soleil)

- Footer avec timestamp de dernière analyse

4. VALIDATION ET TESTING

- CRITIQUE : Utiliser le navigateur intégré pour :

* Inspecter la structure HTML de chaque site cible AVANT de coder les scrapers

* Tester que chaque scraper fonctionne individuellement

* Vérifier l'affichage du rapport avec données réelles

* Valider les animations et la responsiveness mobile

- Créer des screen recordings des tests pour documentation

- Vérifier que le scraping gère les timeouts et erreurs proprement

5. LIVRABLES

- Code Python modulaire (un fichier par scraper + main.py)

- Docstrings complètes avec exemples

- Fichiers HTML/CSS/JS séparés et commentés

- README.md détaillé avec :

* Instructions d'installation

* Guide d'utilisation

* Screenshots du résultat final

* Troubleshooting des erreurs courantes

- requirements.txt pour les dépendances Python

- .gitignore approprié

CONTRAINTES TECHNIQUES :

- Python 3.10+

- Pas de framework backend (Flask/Django) pour rester simple

- Tout en local, pas de déploiement cloud nécessaire

- Compatible Windows 11

RÈGLES DE DÉVELOPPEMENT :

- Suivre PEP 8 strictement pour Python

- Type hints obligatoires

- Commenter les sections complexes

- Privilégier la clarté à la performance

- Chaque fonction doit avoir un seul rôle

- Gestion d'erreurs avec try/except et logs informatifs

- Le design visuel doit être WOW au premier regard - éviter tout style "basic"

WORKFLOW :

1. Créer l'Implementation Plan complet avec architecture détaillée

2. Utiliser le browser pour analyser la structure HTML des 4 sites

3. Développer les scrapers un par un avec tests individuels

4. Créer le système d'analyse de tendances

5. Développer le générateur de rapport HTML

6. Créer l'interface web avec animations

7. Tests d'intégration complets via browser

8. Documentation finale avec screenshots

ATTENDU FINAL :

Une application qui, en un clic, scrappe les 4 sites, analyse les tendances tech émergentes, et génère un rapport HTML

Le mode planning fonctionne comme annoncé : l'agent découpe les étapes de développement, lance Chrome pour analyser les pages à scraper, inspecte les balises via du JavaScript, et sollicite une validation humaine avant chaque exécution de code. Cette friction ralentit le processus, les allers-retours entre l'agent et le navigateur en arrière-plan alourdissent la séquence, mais elle sécurise l'ensemble et écarte le risque d'exécution sauvage. Au final, on obtient un plan de développement structuré, prêt à être exécuté par l'agent. Rassurant, mais chronophage (environ 20 à 25 minutes au total).

Le plan généré par Antigravity :

Implementation Plan - Tech News Analyzer Goal Description Build a "Tech News Analyzer" web application that scrapes 4 major tech, extracts key information, analyzes trends, and presents a premium HTML report. The goal is to automate the gathering of tech news and provide a high-quality visual summary. Proposed Changes Architecture Backend: Python scripts (modular) Data Storage: Temporary data.json Frontend: Generated HTML report + Simple landing page to trigger analysis Server: http.server customized to handle the "Analyze Now" trigger Component: Scrapers (backend/scrapers/) We will implement individual scrapers for each source using requests and BeautifulSoup. Base Scraper: A parent class or utility for common logic (User-Agent rotation, error handling, rate limiting). The Verge Scraper: Target https://www.theverge.com/tech Container: div.duet--content-cards--content-card Title: h2 a or a[href*="/tech/"] (verify specific class duet--content-cards--content-card-link) Date: time Strategy: Fetch detail page for summary if not present (often missing on index). VentureBeat Scraper: Target https://venturebeat.com/category/ai/ Container: article Title: h2 a Summary: p.ArticleListing__excerpt or p.font-paragraph (Available on index). TechCrunch Scraper: Target https://techcrunch.com/category/artificial-intelligence/ Container: li.wp-block-post or div.loop-card Title: a.loop-card__title-link Strategy: Summary missing on index. MUST fetch detail page to get div.entry-content p or meta description. Ars Technica Scraper: Target https://arstechnica.com/ Container: article Title: h2 a Summary: p.excerpt (Available on index). Component: Analysis (backend/analysis.py) Trend Analysis: Load JSON data. Tokenize titles and summaries. Remove stop words. Calculate frequency distribution. Extract top 15 keywords. Component: Report Generator (backend/generator.py) Template System: Use Python's string.Template or f-strings to inject data into a robust HTML structure. Visuals: Chart.js for the "Sources frequency" graph. Wordcloud logic (HTML/CSS based or pre-generated image, or D3.js cloud). Data injection for "Latest News" cards. Component: Web Interface (main.py & frontend/) index.html: Landing page with "Analyze Now" button. main.py: A http.server subclass. GET /: Serves index.html. POST /analyze: Triggers the scraping/analysis pipeline, returns the generated report URL or content. Verification Plan Automated Tests Unit Tests: We will write simple assertions in a tests.py to verify: Scraper functions return dictionaries with expected keys (title, url, etc.). Analysis function returns a list of keywords. Browser Testing: Use browser_subagent to: Visit the generated report.html. Check for console errors. Verify that cards are populated. Manual Verification Visual Check: Verify the "Premium" look and feel (gradients, glassmorphism). Verify responsiveness on mobile view (using browser devtools emulation). Validate the "Analyze Now" flow works from the landing page

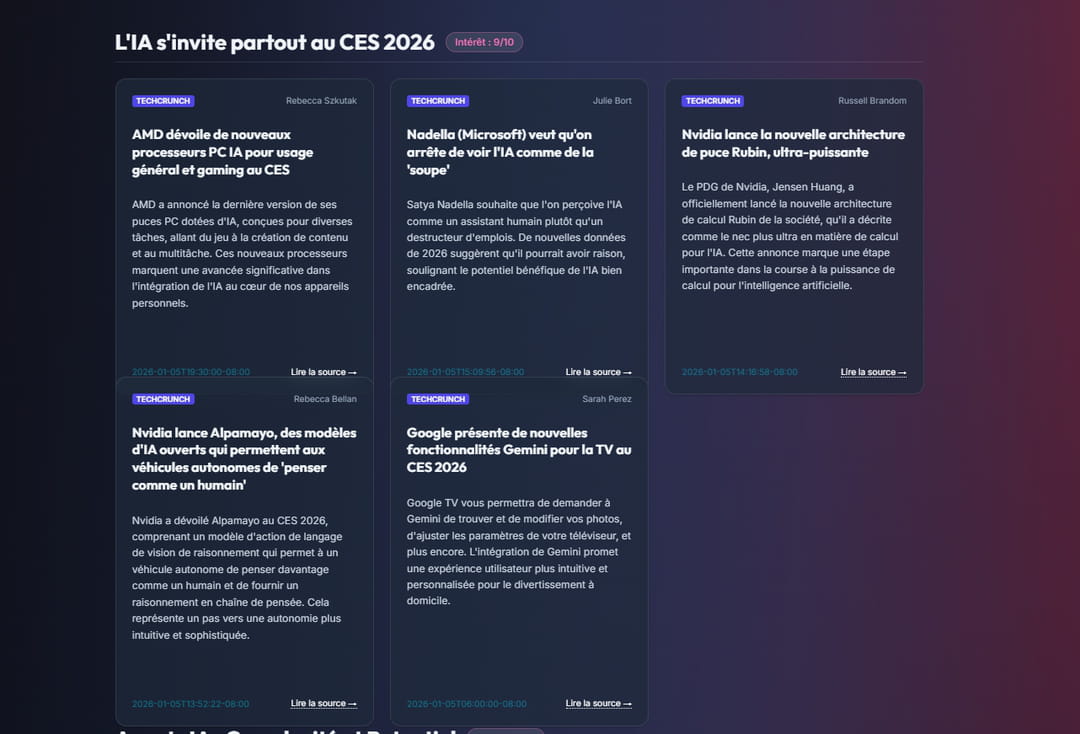

Une fois le plan généré, il est temps de passer à l'action. Nous demandons à l'IA d'exécuter le plan. Le système s'exécute sans accroc, code les fonctions et fichiers demandés. La génération du projet prend plus de temps qu'avec Claude Code, mais le résultat de l'UI est nettement plus soigné. L'utilisation de Chrome embarqué apporte un vrai plus : l'IA peut voir le rendu et implémenter des modifications en direct. La première version est solide mais reste basique. Nous demandons alors à l'IA d'implémenter une clusterisation des sujets par ordre d'importance, le tout en français avec Gemini (via l'API).

L'UI finale est complètement fonctionnelle et opérationnelle. Antigravity a rempli son rôle. Seul problème : après quelques itérations, Antigravity s'est mise à planter et à consommer plus de 5 Go de RAM. Il aura fallu redémarrer pour retrouver un état stable. Serions-nous parvenus au même résultat avec Cursor ou Windsurf ? Oui, très probablement, mais avec quelques itérations supplémentaires.

Un potentiel gâché par l'instabilité

Antigravity fonctionne. L'intégration de Chrome embarqué pour valider visuellement le code produit un vrai différentiel face à Cursor ou Windsurf, et le mode Planning structure efficacement les tâches complexes. Mais au fil des itérations, l'expérience se dégrade : les temps de réponse s'allongent, les plantages se multiplient, et l'application finit par nécessiter un redémarrage complet, à plusieurs reprises. Cette instabilité chronique plombe l'usage quotidien. Soit Google a précipité le lancement d'Antigravity sans investissement suffisant, soit l'architecture même du fork VS Code pose des problèmes structurels que l'équipe n'a pas su résoudre. Dommage, car le potentiel est là.

Pour l'instant, Antigravity reste un terrain d'expérimentation pour développeurs curieux, pas un outil de production quotidienne. L'instabilité technique le disqualifie pour un usage quotidien. Reste à savoir ce que Google compte faire de ce projet. L'éditeur a un historique chargé d'abandons de produits prometteurs. Si Antigravity suit cette trajectoire, il rejoindra le cimetière Google. Si, au contraire, Mountain View investit sérieusement dans la stabilisation et l'optimisation, l'IDE pourrait devenir une alternative crédible à Cursor et Windsurf.