ChatGPT : comment créer dès maintenant son propre assistant grâce à l'interface développeur

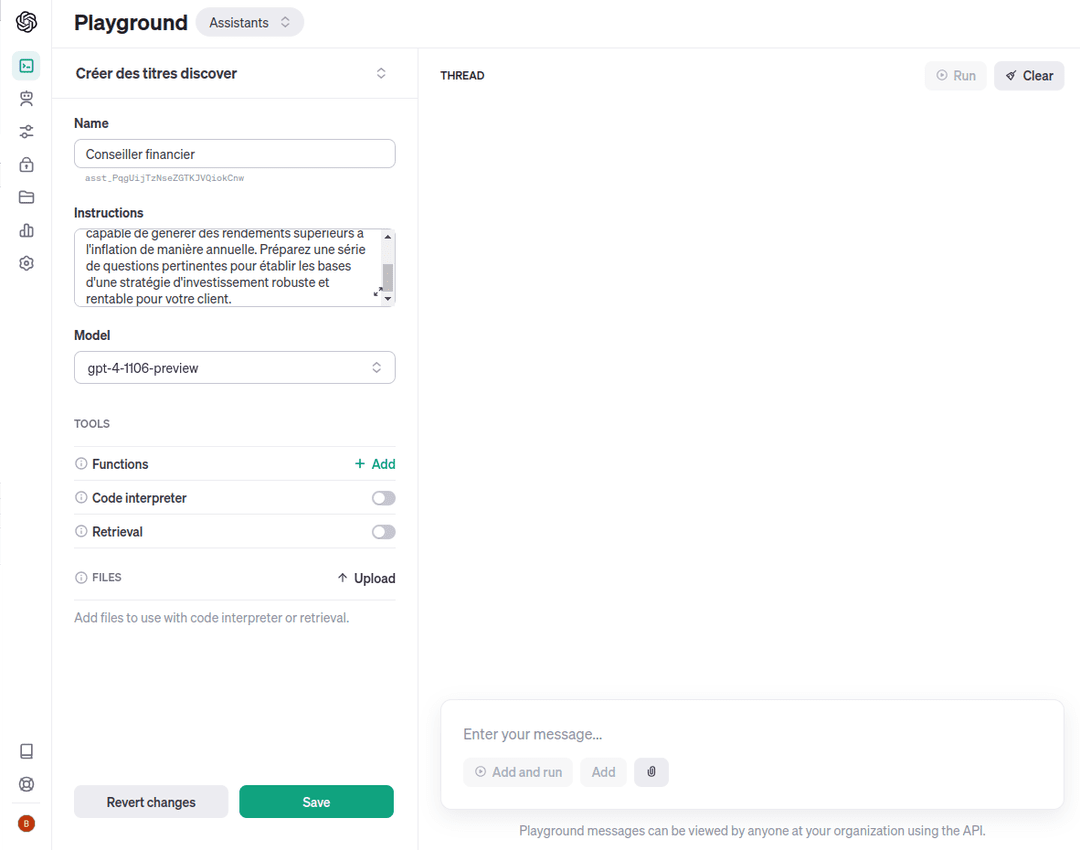

OpenAI vient (encore) de détruire plusieurs centaines de business model tout en créant un nouveau marché. Bien que les GPTs ne soient pas disponibles officiellement dans l'interface classique de ChatGPT, leurs équivalents pour les développeurs, "les assistants" sont déjà disponibles. Nommée "Assistants API", l'interface de programmation permet aux programmeurs de développer des chatbots personnalisés pour une tâche. Disponible sur le site développeur d'OpenAI, l'outil Assistants playground, encore en beta, permet de configurer un copilot depuis une interface graphique et sans code.

Pour explorer les capacités de l'API Assistants, OpenAI rappelle qu'il existe deux options : utiliser le bac à sable Assistants fourni ou créer sa propre intégration étape par étape en suivant le guide. Une intégration typique de l'API Assistants dans un workflow classique suit ces étapes :

-

Créer un Assistant dans l'API en définissant des instructions personnalisées et en choisissant un modèle, avec la possibilité d'activer des outils additionnels.

-

Créer un fil de discussion lorsqu'un utilisateur entame une conversation.

-

Ajouter des messages au fil au fur et à mesure des questions de l'utilisateur.

-

Exécuter l'Assistant sur le fil pour déclencher des réponses et appeler automatiquement les outils pertinents.

Un assistant personnalisé en 3 étapes

Pour créer l'assistant depuis le Playground, rien n'est plus simple. Après avoir renseigné le nom de l'assistant à créer, l'interface demande les instructions à fournir à l'IA. Ces dernières sont en réalité un pré-prompt qui sera exécuté avant chaque début de conversation. Comme avec la version classique de GPT, il est nécessaire de les travailler avec précision. Plus les instructions seront détaillées et précises, meilleures seront les réponses du copilot. Il est aussi possible de faire générer son prompt par GPT-4, comme expliqué précédemment dans nos colonnes.

Une fois le champ d'instruction correctement rempli, il faut choisir le modèle d'intelligence artificielle à utiliser. 9 modèles différents sont proposés :

- gpt-4-1106-preview : dernière version preview du modèle GPT-4 Turbo avec de meilleures capacités d'exécution d'instructions, mode JSON, sorties reproductibles, appels de fonctions parallèles, etc.

- gpt-4-0613 : Instantané du modèle gpt-4 datant du 13 juin 2023 avec une meilleure prise en charge des appels de fonctions.

- gpt-4-0314 : Instantané du modèle gpt-4 datant du 14 mars 2023 avec prise en charge des appels de fonctions. Le modèle sera déprécié le 13 juin 2024.

- gpt-4 : la dernière version de GPT-4, avec les dernières mises à jour.

- gpt-3.5-turbo-16k-0613 : Instantané du modèle gpt-3.5-turbo-16k datant du 13 juin 2023. Il sera déprécié le 13 juin 2024.

- gpt-3.5-turbo-16k : Pointe actuellement vers gpt-3.5-turbo-0613. Pointera vers gpt-3.5-turbo-1106 à partir du 11 décembre 2023.

- gpt-3.5-turbo-1106 : Dernière version mise à jour de GPT 3.5 Turbo avec de meilleures capacités d'exécution d'instructions, mode JSON, sorties reproductibles, appels de fonctions parallèles, etc.

- gpt-3.5-turbo-0613 : Instantané du modèle gpt-3.5-turbo datant du 13 juin 2023. Sera déprécié le 13 juin 2024.

- gpt-3.5-turbo : Pointe actuellement vers gpt-3.5-turbo-0613. Pointera vers gpt-3.5-turbo-1106 à partir du 11 décembre 2023.

La sélection d'un modèle doit correspondre au besoin final. Pour un projet en beta, vous pouvez utiliser un modèle en preview, comme "gpt-3.5-turbo-1106" ou "gpt-4-1106-preview". En revanche, pour un projet destiné à terminer en production, privilégiez un modèle stable sans mise à jour. Il en va de la stabilité de votre projet.

Possibilité d'ajouter des fichiers

Une fois le modèle choisi, il est possible d'ajouter des fonctionnalités. Vous pouvez choisir d'ajouter une fonction pour personnaliser une action spécifique. Plus intéressant, il est possible d'intégrer directement Code Interpreter dans votre assistant. Pratique si vous souhaitez générer et exécuter du code dans votre copilot, ou encore analyser des données. Enfin, nouveauté sans aucun doute la plus intéressante, la possibilité d'activer "Retrieval" pour ajouter des fichiers en base pour le copilot. L'IA se basera alors sur les informations présentes dans les fichiers pour répondre. Attention toutefois, le mode "Retrieval" ne peut être activé qu'avec les modèles "gpt-3.5-turbo-1106" et "gpt-4-1106-preview." La taille maximale d'un fichier est de 512MB.

Après avoir terminé la configuration de l'assistant, il est possible de l'exécuter directement dans le playground, dans une fenêtre de chat. Au fil de vos tests, vous pouvez modifier en même temps les caractéristiques du copilot pour obtenir les meilleurs résultats possibles. Une fois les dernières itérations terminées, il est possible de récupérer directement les paramètres de l'assistant en brut pour les intégrer dans votre code. Exécuter l'assistant depuis "Run" avec un message d'exemple et cliquer sur la dernière requête de type "GET" présente dans les logs de la conversation test.

Pour rappel, Assistants API est encore en version beta. Des bugs peuvent encore se produire et certaines fonctionnalités ou modèles ne sont pas encore pris en charge, c'est notamment le cas de Dall-E.