Mixtral 8x22B face à Llama 3 : l'atout majeur du modèle français

Mistral frappe encore très fort. La start-up parisienne, qui s'apprêterait à finaliser une levée de fonds de 5 milliards de dollars, a dévoilé un nouveau LLM à l'état de l'art open source pendant… 9 jours. Dévoilé le 10 avril sous la forme d'un fichier torrent brut, Mixtral 8x22B a été officialisé par Mistral AI le 17 avril avec de nouvelles informations sur son entraînement. Moins de 24 heures plus tard, Meta a répliqué en dévoilant Llama 3. Un modèle surpassant celui de la start-up parisienne dans les benchmarks. Mixtral 8x22B n'en est pas pour autant à ranger au fond du tiroir, bien au contraire.

Mixtral 8x22B : la puissance d'une architecture SMoE

Le petit dernier de Mistral dispose d'un atout majeur sur Llama 3 : son architecture. Basé sur un modèle de Sparse Mixture-of-Experts, Mixtral est, à paramètres égaux, plus efficace. Popularisé par Mistral AI avec Mixtral 8x7B, l'architecture s'est rapidement développée dans l'écosystème open source. Cette dernière présente un fonctionnement véritablement différent de l'architecture transformer classique, encore utilisée par la majorité des LLMs du marché. Avec une architecture Sparse Mixture-of-Experts, le modèle est constitué de plusieurs agents chacun spécialisé dans certains types de tâches ou de connaissances. Lorsqu'une entrée est présentée au modèle, un mécanisme de "routage" sélectionne dynamiquement quels experts seront activés pour traiter cette entrée de manière optimale.

Contrairement à un modèle dense où tous les paramètres sont utilisés, dans l'architecture SMoE, seuls les paramètres des experts sélectionnés sont activés pour une entrée donnée. Cela rend le modèle plus compact et efficace. Ainsi, à l'inférence, Mixtral 8x22B dispose de seulement 39 milliards de paramètres actifs sur 141 milliards au total. Cette particularité offre une excellente efficacité coût-performance. L'inférence est également beaucoup plus rapide. En parallèle, cette approche facilite l'ajout de nouveaux experts et l'adaptation à de nouvelles tâches.

Concrètement, quand Llama 3 utilise 70 milliards de paramètres en même temps lors de l'inférence, Mixtral n'en utilise que 39. Bien que Meta ait amélioré l'architecture transformer de Llama 3, le modèle français sous-performe légèrement par rapport au géant de Meta mais sera beaucoup plus rapide et moins coûteux à mettre en place au sein d'une infrastructure cloud ou on premise.

Des performances de haut vol

Au cours du développement de Mixtral 8x22B, les équipes de Mistral AI ont focalisé leur attention sur la prise en charge native des langues européennes. Mixtral 8x22B supporte l'anglais, le français, l'italien, l'allemand et l'espagnol. Ses capacités en mathématiques et en compréhension / génération de code ont également été améliorées. Il supporte nativement le function calling qui permet de simplifier l'appel au LLM au sein d'un programme. Le modèle supporte une fenêtre de contexte de 64 000 tokens, permettant de traiter des documents assez longs. Pour comparaison, Llama 3 70B est proposé avec un contexte de 8 000 tokens.

Sur le benchmark MMLU mesurant la compréhension du langage dans de multiples tâches, Mixtral 8x22B affiche un score de 77,75% contre 79.5 pour Meta. Ses performances sur les tests de raisonnement et de connaissances générales comme HellaSwag, Wino Grande et ARC Challenge sont également remarquables, avec des scores autour de 88-91%. Ces bons résultats en font un modèle de choix pour l'analyse de documents complexes. Mixtral 8x22B peut être envisagé comme LLM principal pour un agent personnalisé ou coach dans une grande variété de domaines. Autre point fort, les performances de Mixtral 8x22B en mathématiques et en programmation sont tout simplement les meilleures parmi les modèles de langage ouverts, derrière Llama 3. Avec 88,4% sur HumanEval, 71,2% sur MBPP et 90,8% sur GSM8K, le modèle démontre des aptitudes de premier plan pour les tâches nécessitant un raisonnement complexe. Mixtral 8x22B peut être envisagé comme un très bon modèle pour la génération / compréhension de code. Il peut également être fine-tuné assez facilement sur un langage donné pour être encore plus performant.

|

Benchmark |

Mixtral 8x22B |

Interprétation du benchmark |

|

|

MMLU 5-shot |

79.5 |

77.7 |

Evaluation de la compréhension du langage dans de multiples domaines |

|

AGIEval English 3-5-shot |

63.0 |

61.2 |

Mesure des capacités de raisonnement et de compréhension en anglais |

|

BIG-Bench Hard 3-shot, CoT |

81.3 |

79.2 |

Evaluation des capacités de raisonnement complexe et de génération de texte |

|

ARC-Challenge 25-shot |

93.0 |

90.7 |

Mesure de la compréhension des connaissances scientifiques et du raisonnement |

|

DROP 3-shot, F1 |

79.7 |

77.6 |

Evaluation de la compréhension des textes et du raisonnement |

Le test en conditions réelles

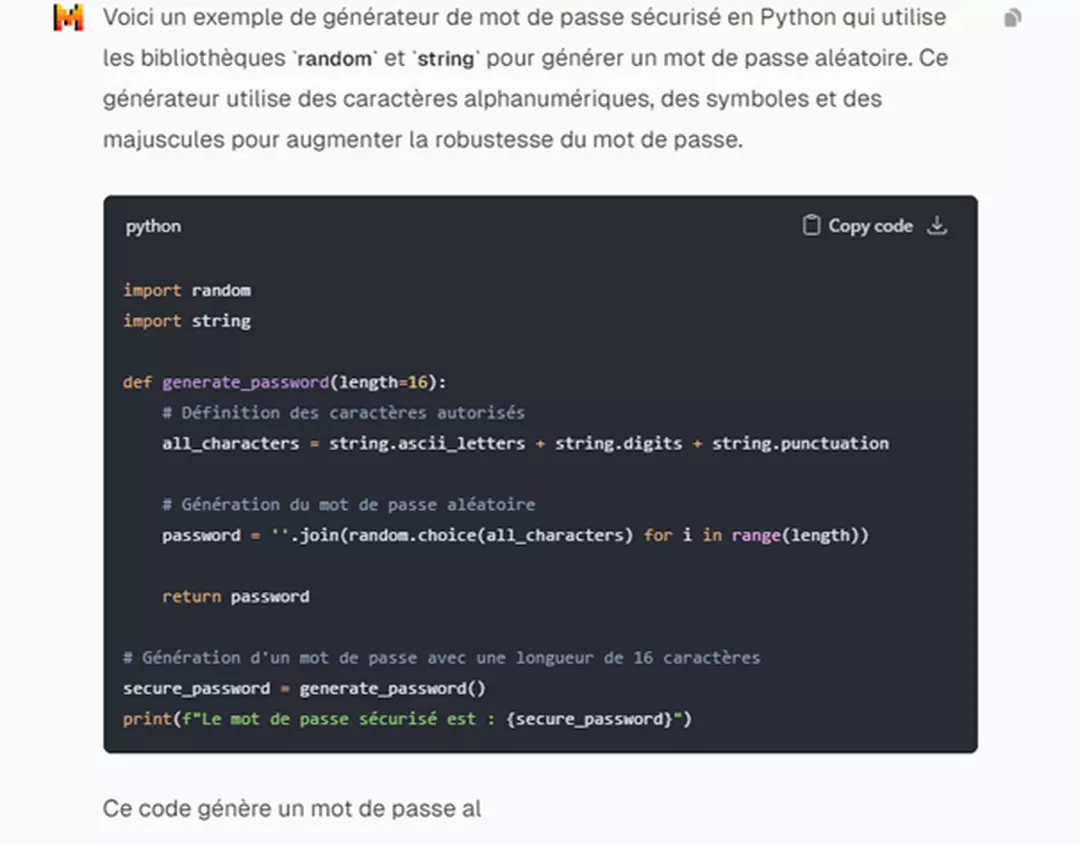

Pour éprouver les capacités de Mixtral 8x22B, nous avons décidé de tester le modèle (version instruct) sur plusieurs cas d'usage courants et de comparer ses performances avec Llama 3 de Meta. Les résultats sont assez intéressants. En génération de code, Mixtral propose un code simple, concis et relativement bien optimisé. Le code manque cependant d'une documentation plus lisible. Llama 3 propose à tâche égale une réponse plus appropriée. Mixtral pourrait cependant mieux performer après un fine-tuning sur un langage spécifique.

En résumé de texte, Mixtral propose un résultat qualitatif, meilleur que Llama 3 selon nos différents tests. En revanche, le modèle de Mistral AI peine à suivre avec une exactitude parfaite le prompt initial. Un prompting plus exigeant semble nécessaire. En génération de texte, Mixtral offre un résultat assez propre du premier coup. Le style est assez verbeux et manque de fluidité. La différence avec Llama 3 est infime. Le modèle de Meta propose quant à lui un texte légèrement plus fluide avec un vocabulaire plus riche et varié. En génération de texte Mixtral reste en retrait et Llama s'impose. Avec un fine-tuning plus poussé sur des textes de qualité, Mixtral pourrait gagner en précision et fluidité, pour un coût inférieur au modèle de Meta.

Mixtral vs Llama, un duel d'IA au sommet

Mixtral, par sa position agressive, s'est hissé en haut du classement des meilleurs LLMs du marché de l'open source pendant 9 jours avant d'être rapidement rattrapé, sur les performances globales par Llama 3 de Meta. Le modèle de Mistral AI est légèrement moins performant que celui de Meta mais offre résolument un compromis fiable et robuste avec une efficience excellente pour la majorité des cas d'usage.

Pour obtenir un résultat véritablement qualitatif, il sera nécessaire de guider le modèle avec un prompt précis et simple. Pour des performances optimales, un fine-tuning peut s'avérer nécessaire. Si Llama 3 s'impose comme le nouveau leader incontesté en termes de performances brutes, Mixtral 8x22B tire son épingle du jeu grâce à son architecture unique et son efficience remarquable.