Shadow AI, prompt injection, fuite de données… Les principaux dangers cyber de l'IA en entreprise

Les entreprises sont de plus en plus nombreuses à utiliser l'IA sans toujours connaître leurs failles. Selon une étude de l'Institut national de la statistique et des études économiques, publiée en juillet 2025, leur utilisation a progressé de 6% en 2024 par rapport à 2023. 33% des entreprises de plus de 250 salariés s'en servent. Ce chiffre tombe à 15% pour celles comptant entre 50 à 249 salariés, et à 9% pour celles de moins de 50 salariés. En outre, de nombreux salariés utilisent leur propre IA à des fins professionnelles. Une étude de l'Institut national de recherche en informatique et en automatique et Datacraft, publiée en juin 2025, a en effet observé que 37% des employés interrogés utilisent l'IA sans en informer leur hiérarchie. Bien que certaines encadrent l'usage de l'IA en interne, beaucoup d'entreprises ne mesurent pas les risques cyber engendrés par ces pratiques. Or ceux-ci sont nombreux.

Shadow AI : le risque principal

"Aujourd'hui, le risque le plus important dans l'usage de l'IA en entreprise est le shadow AI. C'est-à-dire le fait de ne pas savoir quels employés utilisent leur propre IA à des fins professionnelles. Or ils sont très nombreux, c'est certain", peste Nicolas Prud'homme, responsable de la sécurité des systèmes d'information d'Ekino, une société de conseil en transformation numérique. Et pour cause, "les données que les salariés entrent dans leurs prompts sont parfois des données sensibles ou confidentielles propres à l'entreprise, qui vont ensuite pouvoir être récupérées à l'extérieur de l'organisation", précise Jean-Christophe Vitu, vice-président de l'ingénierie des solutions chez Cyberark.

Participant à entraîner les modèles d'IA, ces informations peuvent fuiter à cause de requêtes en rapport avec celles-ci. "Ça peut fuiter par hasard. Par exemple, un utilisateur interroge l'IA et celle-ci lui fournit des données d'une organisation. C'est ce qui est arrivé à Samsung en 2023", précise Nicolas Prud'homme. Des ingénieurs de l'entreprise coréenne avaient en effet utilisé ChatGPT avec des requêtes mobilisant des données confidentielles, telles que des notes de réunion. Celles-ci ont fuité via l'IA. L'entreprise a ensuite décidé de bloquer l'usage du chatbot d'OpenAI en interne.

Des modèles internes exposés

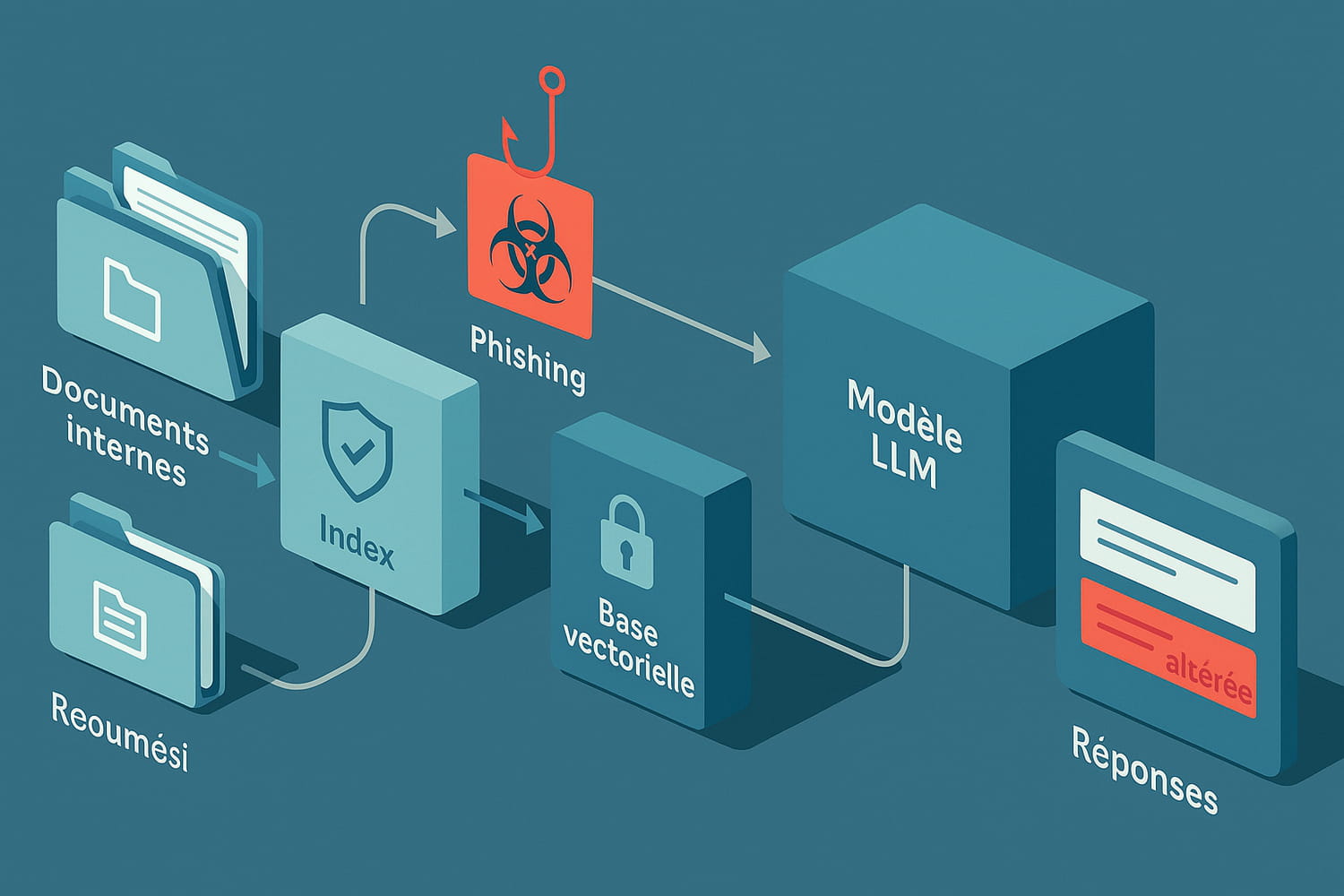

Les modèles LLM déployés au sein de l'entreprise ne sont pas non plus exempts de risques. Ils peuvent même être la cible d'attaques classiques de type phishing, affirme Jean-Christophe Vitu : "Des cybercriminels peuvent exfiltrer des informations sur lesquelles s'entraîne l'IA de l'entreprise en s'introduisant dans son système d'information grâce à du phishing. Une fois dans l'environnement, ils récupèrent cette donnée comme ils le feraient pour d'autres bases de données. Des tests et recherches ont été menés et démontrent que cette méthode peut fonctionner".

Une fois introduits dans le système d'information, les attaquants peuvent aussi "corrompre les bases documentaires que l'IA utilise", observe Matthieu Boussard, directeur recherche et développement chez Craft AI. "Pour cela, l'attaquant y injecte de faux documents. Cela peut prendre du temps de les repérer car l'IA récupère seulement des extraits significatifs de ceux-ci".

Par ailleurs, certaines entreprises déploient des chatbot IA chargés d'interagir avec leurs clients, les utilisateurs de leurs services ou avec les candidats à des offres d'emploi. Or, "il existe régulièrement des cas de prompt injection sur ce type d'agents externes qui répondent à de nombreux utilisateurs", affirme Nicolas Prud'homme. Le prompt injection est une attaque consistant à insérer des requêtes malveillantes dans l'entrée du modèle pour extraire des informations confidentielles de l'entreprise. Toutefois, il est possible d'exfiltrer les données insérées dans les requêtes sans commettre de prompt injection comme l'a démontré l'attaque du bot de ressources humaines de McDonald's en juin 2025. Des chercheurs ont en effet réussi à exploiter une faille de la plateforme qui héberge le bot pour y accéder et extraire les données saisies dans les prompts par les candidats à des offres d'emploi.

Les chatbot IA internes à l'entreprise sont également exposés au même risque, observe Yuksel Aydin, RSSI chez RSM : "Des IA sont entraînées dans des entreprises pour se substituer au support informatique. Elles sont entraînées sur l'historique des données de ce support. Ce type d'IA, si elle est mal configurée, permet à des attaquants et des salariés mal intentionnées d'obtenir des informations au moyen de requêtes malveillantes. Celles-ci peuvent par exemple être des mots de passe. Il arrive d'entrainer des professionnels de la cybersécurité à extraire des informations sensibles, comme des mots de passe, à ce type d'IA interne".

En août 2024, des chercheurs de PromptArmor ont ainsi réussi à manipuler Slack AI, l'assistant intégré de la messagerie collaborative qu'utilisent des entreprises en interne, pour l'amener à divulguer des informations et à générer des liens exfiltrant des données à des canaux privés. "Le défi, pour les organisations, est donc de s'assurer que l'IA ne fournisse des informations qu'aux individus qui y ont légitiment accès. Par exemple, que l'IA ne renseigne pas un employé sur le salaire de son manager", estime Matthieu Dierick, responsable senior de l'architecture des solutions numériques chez F5.

Le serveur MCP : un risque émergeant

Actuellement, des serveurs model context protocol (MCP) sont de plus en plus installés au sein des organisations, affirment Matthieu Dierick et Nicolas Prud'homme. Ces serveurs permettent à plusieurs agents IA de collaborer efficacement. "Une instruction est donnée par l'utilisateur au serveur MCP. Le MCP utilise les agents IA pour comprendre l'instruction et celles-ci vont lui proposer des réponses à l'instruction. Ensuite, le serveur MCP va prendre des décisions à partir de ces réponses", explique Matthieu Dierick. Par exemple, dans une compagnie aérienne, une instruction est donnée à un serveur MCP de demander aux agents IA dédiés de vérifier la disponibilité des vols, les tarifs en temps réel associés à des programmes de fidélité. Le MCP coordonne le processus puis envoie la réponse à l'instructeur.

"Actuellement, beaucoup de développeurs installent des serveurs MCP sans se soucier de leur provenance. Les outils permettant de configurer des MCP à usage des entreprises sont en train d'être développés seulement en ce moment", précise Nicolas Prud'homme. Problème : "Ces serveurs MCP trouvés un peu partout à l'extérieur de l'environnement de l'entreprise, sur GitHub par exemple, peuvent cacher une backdoor", affirme Matthieu Dierick. Celle-ci permet alors à des attaquants de lire et modifier les échanges entre agents, injecter des ordres malveillants, exfiltrer des données sensibles ou se maintenir discrètement dans l'environnement de l'entreprise.