Moteurs IA : des robots très actifs sur les sites des annonceurs

Google domine encore la recherche (91,8 %), mais les IA (ChatGPT, Gemini, Perplexity…) montent à 8,2 %. Paradoxe : elles vivent du web humain tout en menaçant de le vider de sa substance.

Le géant de Mountain View continue de dominer le marché de la recherche en ligne. C’est ce que révèle l’étude « AI Search vs. Google » réalisée par WIX STUDIO. Si les nouveaux moteurs LLM – ChatGPT, Gemini, Claude, Perplexity, Copilot de Microsoft et Grok d’X – ont réussi en quelques mois à atteindre une part conséquente de 8,2 % du trafic général, le géant qui conservait 91,8 % de part d'usages cet été, s'est lui-même lancé dans le domaine, quitte à cannibaliser son business avec Gemini pour rattraper les parts des LLM concurrentes.

Les LLM parcourent plus le web que l’on le pense

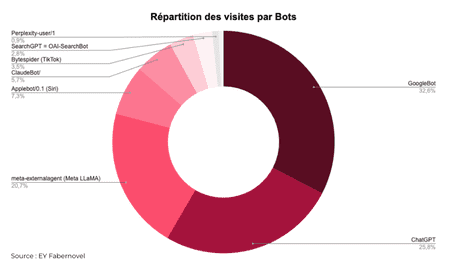

En menant ma propre étude sur la base des fichiers logs du site web d’un grand fournisseur d’énergie pendant une semaine de juin dernier – véritables carnets de bord enregistrant chaque visite sur le site – j'ai pu constater que la répartition des passages entre les bots de Google et ceux des moteurs LLM comme ChatGPT, Perplexity AI (cf graph) était presque aux antipodes de leur part de marché respective.

Certes la firme de Mountain View reste le premier visiteur. Mais il ne représente qu’un tiers de l’ensemble des passages effectués par des bots, une situation nettement contrastée par rapport à sa position monopolistique sur le marché. Par ailleurs, bien que l’échantillon soit limité, sur deux des sept jours analysés, il n’a pas été le visiteur principal, devancé une fois par ChatGPT et une autre fois par Meta.

La dissonance entre le nombre de requêtes traitées par le leader de la recherche d’une part et par l’ensemble des moteurs IA d’autre part, nous force à s’interroger sur la prétendue omniscience qui était la promesse de base de ces intelligences artificielles. Ayant été entraînées sur de large corpus de texte relevant souvent de la culture générale, ces IA devaient tirer leurs forces par leur capacité de calcul à choisir les suites de mots les plus probables à une requête. Cependant, la forte activité des bots de ces LLM sur les sites d'annonceurs semblent montrer le contraire. Elles semblent démunies lorsque les recherches des utilisateurs concernent des entreprises, des marques et ou des produits. Elles parcourent ainsi le web bien plus souvent qu’elles ne le laissent entendre.

Dans un contexte où ces nouvelles technologies provoquent désormais des baisses de trafic avérées chez les annonceurs alors même qu’elles dépendent du contenu original créé par les entreprises pour nous répondre, cette découverte peut nous laisser songeur. D'ailleurs, pour corroborer à cette hypothèse, une autre étude menée par Alexis Rylko, révélait que près de 90 % des sources citées par SearchGPT correspondent au top 10 de la SERP de Google – preuve supplémentaire de cette dépendance.

Paradoxe de la poule et de l’œuf

Et c’est bien là que se dessine l’enjeu stratégique : si les moteurs IA ambitionnent de se substituer au géant de la recherche, ils ne demeurent en réalité pas moins tributaires de la production des éditeurs. Or, si le trafic humain vers les sites venait à se tarir du fait de leurs présences, la création de contenu s’arrêterait faute de résultat, privant ces mêmes IA de leur matière première. La véritable question n’est donc pas seulement celle du partage de parts de marché, mais bien celle de la soutenabilité de l’écosystème du web face à ces nouvelles dynamiques.

Rapprochons-nous à terme de la théorie du “Dead Internet” ? Cette théorie qui considère que la majorité du réseau Internet n’est pratiquement générée plus que par et pour des bots, marginalisant l’activité humaine. Nombre d’œuvres de science-fiction, dépeignent des IA s’affranchissant de ses créateurs pour notre plus grand drame. Et si, depuis toujours, les auteurs s’étaient fourvoyés, et que finalement, c'était l’humain — et non l’IA — qui s’émancipait ?