Comment bien utiliser le fichier LLMs.txt ?

Dans la jungle du référencement associé aux LLM, le fichier LLMs.txt pouvait faire figure de phare dans la nuit. Une balise au milieu de l'océan mouvementé du développement des IA génératives. Le fichier LLMs.txt est une initiative pour offrir aux sites web un outil de régulation spécifique de l'usage de l'intelligence artificielle. Proposé par Jeremy Howard, fondateur d'Answer.AI, cet outil aurait dû devenir le cousin du fichier robots.txt. En fait, même si le nom LLMs ressemble au niveau de l'écriture à celui de robots.txt, ce n'est pas exactement l'équivalent pour les systèmes IA. En effet, contrairement au fichier robots.txt, le fichier LLMs.txt ne gère pas l'indexation des robots d'exploration. Il s'agit plutôt d'une sorte de sitemap.xml qui guide les modèles d'IA vers le contenu le plus précieux.

"Un fichier LLMs.txt est un guide élaboré qui indique aux assistants d'intelligence artificielle tels que ChatGPT, Claude et Gemini où trouver votre contenu le plus important. Au lieu de laisser l'IA parcourir votre site au hasard, vous la dirigez vers vos FAQ, votre documentation, vos politiques et vos guides clés", détaille Giovanni Brando Dalla Rizza, CEO de Naniza. "L'avantage ? Lorsque quelqu'un interroge une IA sur votre entreprise, celle-ci puise dans votre contenu officiel et précis, et non dans des informations tierces périmées. Cela signifie une meilleure visibilité dans les réponses générées par l'IA, une représentation plus précise de la marque et des temps de réponse plus rapides de l'IA, puisque vous proposez un contenu propre et structuré."

Une utilité encore incertaine

Le fichier LLMs.txt peut potentiellement donner aux éditeurs un peu plus de contrôle dans cet écosystème souvent insatiable. Mais celui-ci n'a pas une utilité encore confirmée en tant que norme Web. "A l'exception d'Anthropic de Claude, aucun des principaux fournisseurs de modèles linguistiques n'a confirmé qu'il utilisait le LLMs.txt ", rappelle Olaf Kopp, cofondateur d' Aufgesang GmbH. "Google parle même du fait que le LLMs.text est aussi insignifiant que les Meta Keywords. Des tests ont montré que les robots d'intelligence artificielle n'appelaient même pas le fichier." "Cela se confirme quand on effectue une analyse des logs. Il y a très peu de hits des principaux bots LLMs sur ces fichiers", assure David Groult, head of SEO chez Noiise. "L'implémenter ne ferait pas une grande différence actuellement", avance Olaf Kopp.

Une mise en place facile

Alors que le référencement appliqué aux LLM n'en est qu'à son balbutiement, s'intéresser à ce fichier permet cependant d'anticiper l'avenir. D'autant que sa mise en place est rapide. "Dans le fichier LLMs.txt devraient figurer les contenus les plus importants avec le titre principal, le titre de la page et un bref résumé avec des markdowns", conseille Olaf Kopp. Rappelons que les Markdowns désignent un langage de balisage léger créé en 2004. Il doit permettre de garantir la compatibilité avec les modèles de langage et les agents capables de lire et d'interpréter le fichier.

Le fichier LLMS.txt, comme l'édicte le protocole, doit d'abord être placé à la racine du domaine : comme par exemple : https://votresite/LLMs.txt. Autre demande de Jérémy Howard, écrire sur le fichier un H1 avec le nom du projet ou du site. C'est la seule section obligatoire. Une citation avec un court résumé du projet, contenant des informations clés nécessaires à la compréhension du reste du fichier est préconisée. Des sections Markdowns standards, qui donnent un contexte supplémentaire, sont éventuellement suggérées. "Chaque "liste de fichiers" est une liste de Markdown, contenant un hyperlien Markdown obligatoire [nom](url), puis, éventuellement, un : et des notes sur le fichier."

Voici un exemple générique de fichier LLMS.txt donné par Jérémy Howard :

# Titre > Description facultative Détails optionnels ## Nom de la section - [Link title](https://link_url): Détails du lien optionnel ## Facultatif - [Link title](https://link_url)

Concernant les pages à mettre en avant, il s'agit de se concentrer sur celles répondant à des questions spécifiques, bien structurées, et utilisant si possible l'EEAT. Les pages de service de niveau supérieur, les guides détaillés ou les articles de blog bien structurés pourraient faire partie de cette sélection.

Des outils gratuits

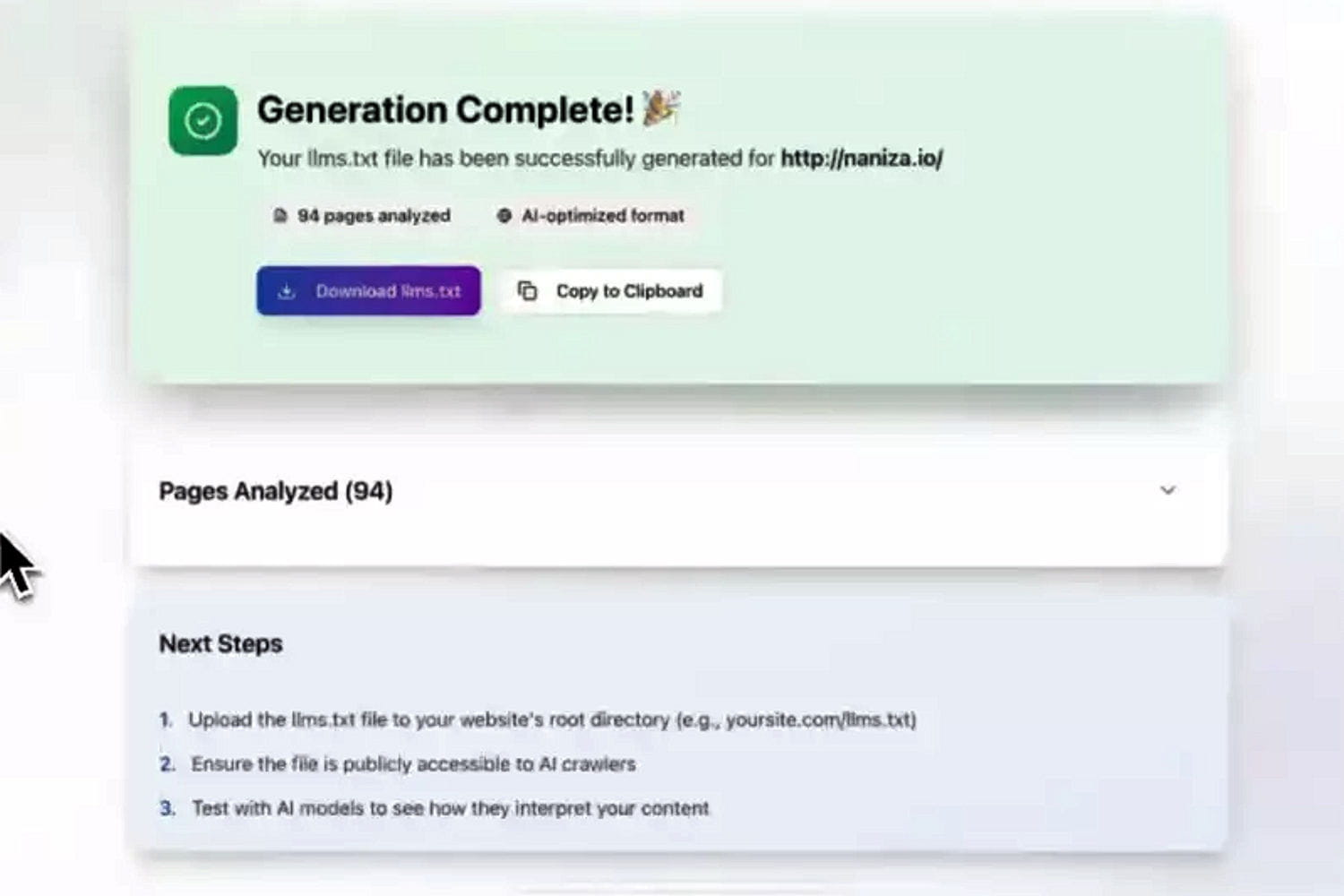

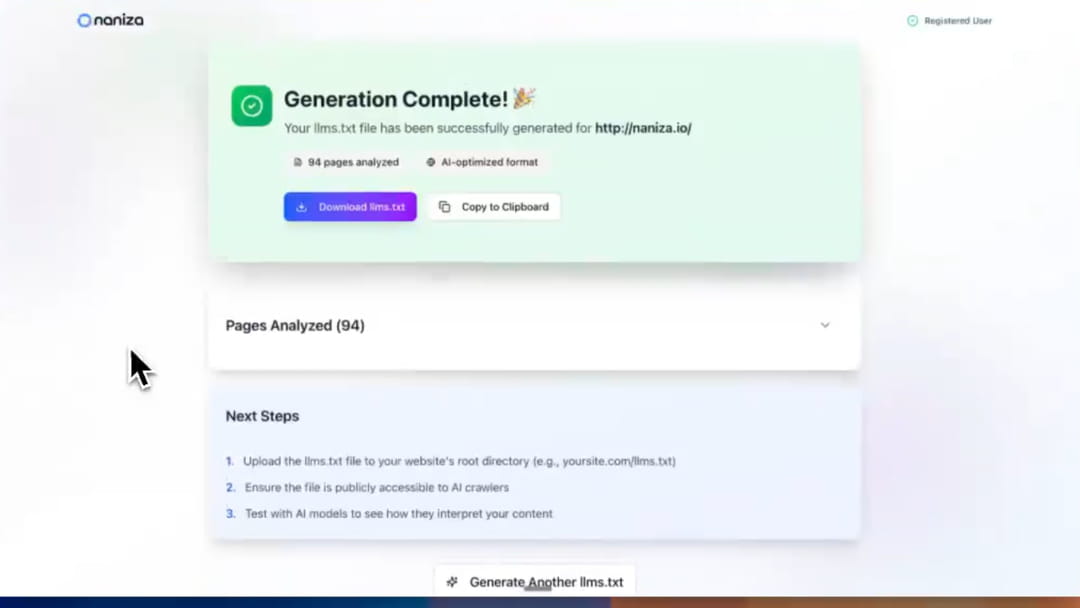

Pour créer ces fichiers, il existe quelques outils gratuits, comme Writesonic, Wordlift ou Keploy. Giovanni Brando Dalla Rizza propose CrawlPulse, qui se veut simple d'utilisation. "Vous entrez l'URL de votre site web et nous explorons automatiquement chaque page, extrayons le contenu significatif tout en ignorant les publicités et l'encombrement de la navigation, et utilisons l'IA pour créer des résumés concis de chaque page. Nous notons et organisons ensuite les pages, en fonction de leur importance, de leur fraîcheur et de leur lisibilité par l'IA, en les regroupant dans des catégories logiques. Le résultat est un fichier LLMs.txt parfaitement formaté et prêt à être téléchargé sur votre site web."

Pour lui, "les avantages du fichier sont clairs : aucune maintenance une fois l'installation terminée, des résumés optimisés par l'IA pour chaque page, un filtrage automatique du contenu de mauvaise qualité et des analyses à venir pour suivre l'engagement de l'IA. En somme, vous préparez votre présence sur le web à la recherche pilotée par l'IA."

Lisibilité et pertinence

Notons que, de con côté, plutôt que "de placer trop d'espoir dans le LLMs.txt ", Olaf Kopp recommande de se concentrer sur l'optimisation de la LLM Readability et de la Chunk Relevanz. Le premier élément, la lisibilité, décrit la capacité du contenu à être traité et capturé par les LLM. Sont importants : la pertinence des informations, l'utilisation du langage naturel, la structuration, la hiérarchie de l'information, la gestion du contexte et le temps de chargement.

La pertinence des fragments renvoie notamment à la capacité d'un bloc à être capturé et traité par les LLM. A élaborer dans ce sens : des paragraphes clairs et courts avec des sous-titres, des questions comme sous-titre et une similarité sémantique entre la requête de recherche et le fragment, déterminée par similarité cosinus ou produit scalaire.