Comment surmonter le vieux casse-tête informatique des bureaux distants ?

La hausse des coûts informatiques, l'évolution des défis en termes de sécurité et de modèles commerciaux font qu'il est indispensable de fournir des services informatiques avancés et efficaces aux sites distants qui ne disposent pas d'un administrateur IT ou d'un serveur.

Pour de nombreuses entreprises, des commerçants, aux chaînes de restaurants, en passant par les services de santé et administratif, les antennes locales sont le principal point d'interaction et de rencontre avec le client. C’est à cet endroit que, la satisfaction initiale du client se forme et la fidélisation se construit. Bien souvent situés loin des installations principales, en général ces sites ne disposent pas d'un personnel informatique important et manquent de ressources techniques. Pour autant, ils ont besoin d'applications de service client avancées avec des capacités de traitement locales. Or, si chaque succursale doit avoir son propre système informatique configuré et déployé séparément, les coûts sont astronomiques. Par conséquent, l'informatique de périphérie, pour les bureaux distants se traduit souvent par une recherche permanente du bon équilibre entre gestion des coûts et optimisation de la satisfaction client.

Résoudre le challenge informatique des succursales et des sites distants est désormais un élément clé de la réussite commerciale des organisations ramifiées. La hausse des coûts informatiques, l'évolution des défis en termes de sécurité et de modèles commerciaux font qu'il est indispensable de fournir des services informatiques avancés et efficaces aux sites distants qui ne disposent pas d'un administrateur informatique sur place ou d'un serveur. Comme toujours, il faut y parvenir sans grever davantage des budgets informatiques souvent à la baisse.

Toutefois, les approches les plus communes visant à étendre la technologie des datacenter aux succursales ont souvent échoué. Si l'adoption du cloud et du SaaS a aidé, le cloud ne peut pas satisfaire tous les besoins informatique. En termes de sauvegarde locale, de récupération, de cybersécurité et, plus généralement, de gestion des données (la mobilité des données pour la réplication, l'archivage, le développement et les tests), les approches existantes ne permettent pas d'atteindre ces objectifs. La mise en place d’une nouvelle stratégie est nécessaire pour réduire le coût total de possession et permettre de disposer des mêmes capacités que le système informatique de base et le centre de données pour transformer les processus, la vitesse et la réactivité de vos systèmes informatiques périphériques.

De nouvelles solutions IT

Pour la plupart des entreprises, les succursales et sites distant sont essentiels à la satisfaction client et donc à la réussite de l'entreprise. Elles luttent pour trouver des solutions qui leur permettent de faire évoluer les technologies de l'information de manière appropriée et de gérer les données distantes plus efficacement. Il existe des solutions, mais peu d'entre elles permettent de rendre l'infrastructure informatique plus simple, plus sûre et plus facile à gérer. En réalité, c'est le contraire qui est vrai. Les solutions apportées sont souvent des solutions ponctuelles qui nécessitent plus de ressources techniques dédiées. Leur déploiement et leur maintenance ajoutent de la complexité, ils ne la diminuent pas. Ainsi, pour beaucoup, la situation se résume à essayer de conjuguer les technologies de périphérie héritées avec des technologies de datacenter qui se veulent le plus moderne possibles.

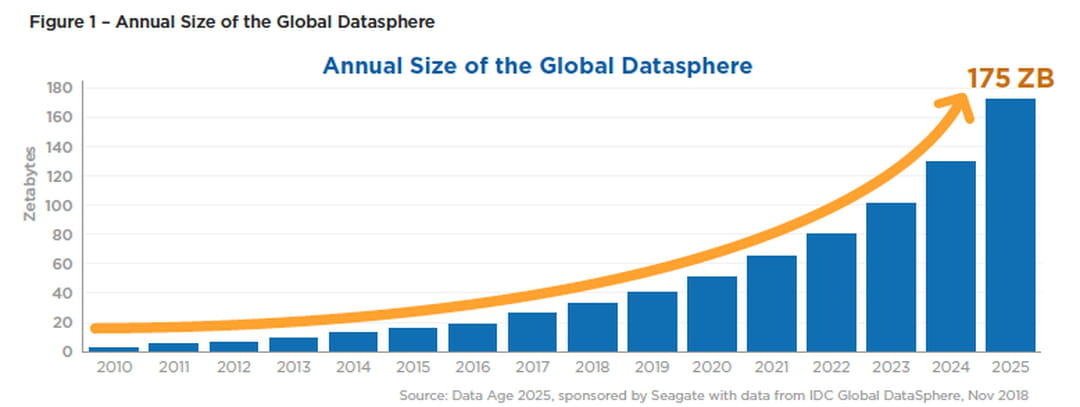

Il existe trois principaux lieux d'utilisation et de collecte des données : le cœur (des datacenter traditionnels et sur le cloud, généralement dans les sites principaux bureaux), la périphérie/edge (infrastructure existante renforcée dans les succursales et les sites mineurs qui ne peuvent pas justifier une assistance humaine permanente sur place) et les endpoints (PC, appareils mobiles et capteurs et dispositifs Internet). Les analystes d'IDC appellent l’ensemble de ces données la "sphère de données mondiale" (Global Datasphere). Et, elle connaît une croissance énorme. IDC prédit[1] que la Global Datasphere va quintupler, passant de 33 Zettabytes (ZB) en 2018 à 175 ZB en 2025.

Le temps réel : la nouvelle norme

Contrairement aux bureaux centraux où les systèmes informatiques disposent d'un support technique sur place, les bureaux secondaires n'en ont pas et sont à la charge des équipes informatiques centrales. Avec l'augmentation des exigences en matière d'applications, de nouvelles approches sont nécessaires pour réduire cette charge et empêcher que l’IT ne constituent un goulot d'étranglement pour l'innovation. La mise en place de systèmes informatiques pour une nouvelle succursale ou un nouveau bureau doit pouvoir se faire en quelques heures, et non en quelques jours.

Les utilisateurs s'attendent à pouvoir accéder aux produits et aux services où qu'ils soient, quelle que soit la connexion dont ils disposent et quel que soit l'appareil utilisé. Ils veulent des données sur le moment, en déplacement et personnalisées. Les systèmes informatiques core et périphérique doivent donc être en mesure de fournir les données précises dont les consommateurs ont besoin, souvent en temps réel. IDC prévoit qu'en raison de la prolifération des données dans nos flux de travail et nos flux de vie personnels, près de 30 % de données mondiales sera en temps réel d'ici 2025[1]. Les entreprises qui cherchent à offrir une expérience client supérieure et à accroître leur part de marché doivent disposer d'infrastructures de données capables de répondre à cette croissance des données en temps réel.

D'ici 2024, IDC s'attend[2] à ce que le stockage en périphérie connaisse également une croissance significative, à mesure que les services et les applications sensibles à la latence prolifèrent dans le monde entier.

Les données ne doivent pas devenir un fardeau

Aujourd'hui, même les données créées, stockées et gérées par les systèmes informatiques centraux finissent dans des silos fragmentés. Si l'on ajoute à cela l'informatique des bureaux distants, on obtient des silos de silos. Le défi est réel. Les entreprises commencent à comprendre l'intérêt de mettre les données au service de la connaissance, mais elles ne savent pas encore comment le faire de manière efficace, sûre et rentable. Actuellement, chaque système crée ses propres données ; chaque système gère son propre environnement. Les données sauvegardées le sont comme une police d'assurance, qui ne peut pas générer de valeur ; elles finissent par être des données sombres. Incapables de fournir de la valeur à l'entreprise, elles sont stockées pour une récupération qui pourrait ne jamais être nécessaire.

Les entreprises de toute taille et de toute maturité ont un problème commun. Une croissance de la fragmentation des données ; des données dispersées sur une myriade de sites différents, des infrastructures en silos et des systèmes de gestion qui empêchent l'organisation d'utiliser pleinement sa valeur. Une enquête récente[1] menée par Vanson Bourne a révélé que 35 % des personnes interrogées ont déclaré utiliser au moins six solutions différentes pour gérer toutes leurs opérations de données non critiques. Plus de 10% des organisations utilisent au moins 11 solutions. C'est surprenant, chacune d'entre elles ayant des coûts de licence, chacune ne pouvant pas fonctionner avec les autres. Le résultat net ? Les données sont devenues un lourd fardeau, alors qu'elles devraient être un atout à valeur ajoutée et compétitif.

La solution : gérer des données en croissance rapide dans des bureaux éloignés

Les cas d'utilisation qui reposent sur l'informatique de périphérie augmentent rapidement et, par conséquent, 30% des charges de travail des entreprises seront en périphérie d'ici 2025 selon Gartner, ce qui souligne la nécessité d'une approche unifiée pour gérer et protéger les données générées ou stockées en périphérie de la même manière que les données d'entreprise situées au niveau central ou gérées dans des environnements de cloud public.

Les entreprises ont besoin d'une solution qui réponde aux problèmes d'administration, de sécurité, de latence et de bande passante sur les sites distants, tout en respectant les préoccupations de récupération des données et les mandats de conformité du siège social. Les administrateurs ont besoin d'un moyen facile à utiliser pour exécuter les opérations de gestion de manière centralisée, par exemple en créant des politiques simples pour la sauvegarde et la récupération sur plusieurs sites, ainsi que des politiques de réplication des succursales qui garantissent qu'une copie des données est disponible à partir du datacenter ou du cloud en cas de défaillances locales.

Ce type de plateforme permettrait une grande résilience des données et la possibilité de répliquer ou d'archiver de manière transparente les données vers le core ou le cloud public. Elle pourrait ensuite contribuer à réduire considérablement l'empreinte des données et l'utilisation de la bande passante du réseau étendu à partir de sites distants grâce à la déduplication et à la compression globales à fenêtre glissante de longueur variable. Enfin, et ce n'est pas le moins important, cela pourrait être un grand pas en avant vers une approche intégrée de la cybersécurité avec un système de fichiers immuable, le chiffrement des données et des capacités anti-ransomware.

Conclusion : adoptez une approche globale de vos données

Il est important pour les entreprises d'adopter une approche globale de leurs données afin d'offrir un faible temps de latence, une meilleure expérience client et de répondre aux pressions réglementaires et de conformité qui obligent les opérateurs à localiser les données dans les régions où se trouvent les clients. Que ce soit dans leurs propres datacenters ou via des fournisseurs de services clouds, les entreprises doivent déterminer quelles données doivent être situées le plus près possible de leurs clients et à quel endroit du réseau elles doivent être situées (cœur ou périphérie, cloud ou datacenter).

On recherche des données intelligentes pour piloter nos entreprises et nos vies en temps réel et en déplacement. Souvent, les données n'ont pas le temps de se déplacer d'un point d'extrémité à un point central et vice-versa lorsqu'il s'agit de prendre des décisions en temps réel. L'avantage de l'entreprise contribue à combler ce fossé. Qu'il s'agisse d'analyse de données ou simplement de stockage de données analysées et intelligentes, l'avantage jouera un rôle croissant dans la mise en place d'un monde en temps réel.

Si vous disposez d'un parc informatique en pleine expansion, vous devez vous demander à quel point vous appréciez la possibilité de gérer facilement toutes vos données et applications sensibles sans latence sur les sites centraux, le cloud et l'infrastructure de périphérie, et quel serait le retour sur investissement pour votre entreprise si vous mettiez en place une capacité informatique de périphérie plus efficace. Le monstre informatique actuel vous a peut-être servi jusqu'à présent, mais pouvez-vous vous permettre de ne pas moderniser

[1] Secondary Data Market Study, Vanson Bourne, 2018.

[1] IDC Whipepaper “Data Age 2025 - The Digitization of the World: From Edge to Core”, Nov. 2018

[1] IDC Whipepaper “Data Age 2025 - The Digitization of the World: From Edge to Core”, Nov. 2018

[2] IDC Whipepaper “Data Age 2025 - The Digitization of the World: From Edge to Core”, Nov. 2018