Informatique quantique : changement de paradigme pour les technologies de l'information ?

Il y a une quarantaine d'années, Richard Feynman posait comme postulat que les systèmes quantiques pouvaient être simulés de manière beaucoup plus efficace en utilisant du matériel informatique fonctionnant en mécanique quantique. Mais que signifie "fonctionner en mécanique quantique" ? Et est-ce une révolution ?

En mécanique quantique, les informations sont stockées et traitées dans un système qui obéit aux lois de la mécanique quantique et que ces lois constituent la base du traitement de l'information. Pour ce faire, il faut introduire le concept de bit quantique (qubit) : un système quantique à deux niveaux doté de certaines propriétés remarquables. L'information dans un processeur quantique est encodée dans les états de ses qubits. Pour comprendre le fonctionnement d’un ordinateur quantique, nous allons présenter trois des concepts les plus centraux pour le traitement des informations quantiques : la superposition, la décohérence et l’enchevêtrement.

États de superposition

Contrairement au bit classique, où l'information est représentée par les états "marche" ou "arrêt" d'un transistor, voir la figure 1 (a), un qubit ne se limite pas à être dans les états "0" ou "1", mais il peut en fait être dans les deux en même temps, voir la figure 1 (b). Ce phénomène est un concept fondamental de la physique quantique, connu sous le nom de superposition. Mathématiquement, nous pouvons représenter l'état qubit (malgré la mise en œuvre physique) comme un point sur une sphère unitaire, connue sous le nom de sphère de Bloch.

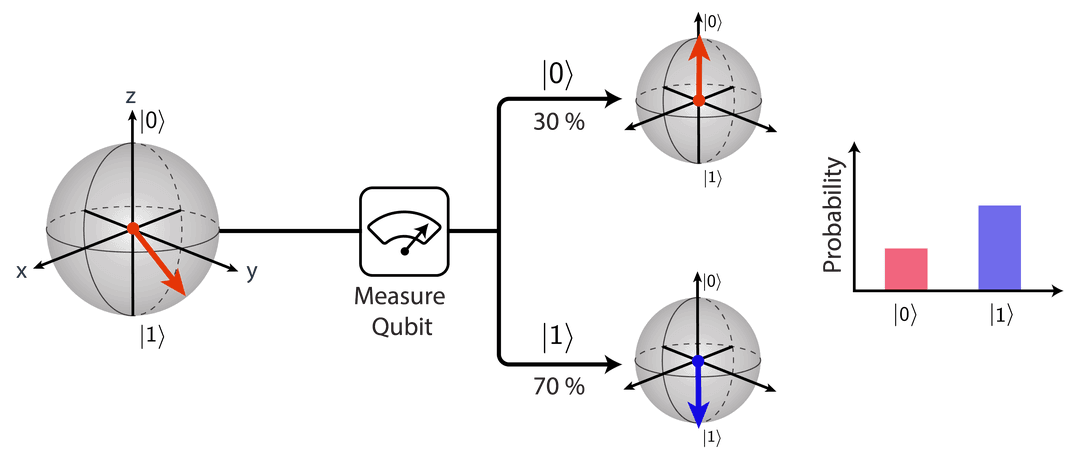

La superposition reflète la nature statistique de la mécanique quantique et est maintenue aussi longtemps que le système n'est pas observé (ou mesuré). Lorsque nous effectuons une mesure de l'état quantique, le système s'effondre dans un état spécifique, avec une probabilité de se retrouver dans l'un des deux états donnés par la "latitude" des coordonnées d'état sur la sphère de Bloch, voir Fig. 2. Un exemple célèbre de superposition est l'expérience de pensée du chat de Schrödinger, qui est à la fois mort et vivant, jusqu'à ce qu'il soit observé. Pour cette raison, nous devons garder le qubit protégé et non observé pendant toute la durée d'un algorithme quantique.

Décohérence ou la perte de "quantumness"

Bien que l'idée d'un processeur quantique existe depuis longtemps, il n'y a pas encore de réalisation à grande échelle d'un ordinateur quantique. L'une des principales raisons pour lesquelles un ordinateur quantique est si difficile à construire est que la durée de vie de la superposition des qubits est limitée. L'un des principaux défis pour les ingénieurs quantiques est donc de construire des systèmes quantiques ayant une durée de vie aussi longue que possible, sans compromettre les performances du processeur.

La perte de cohérence quantique est connue sous le nom de décohérence et a une raison sous-jacente très fondamentale, abordée dans la section précédente, à savoir que les superpositions quantiques s'effondrent dans des états classiques, lorsqu'elles sont mesurées. Cela se produit indépendamment du fait qu'il s'agisse d'une mesure intentionnelle effectuée par un observateur ou d'un bruit ambiant : le système quantique ne peut tout simplement pas faire la différence.

La mesure du temps de cohérence du qubit est donc l'une des pierres angulaires de tout laboratoire quantique, car elle fournit des informations importantes sur la qualité du qubit lui-même et de son blindage, sur la manière dont il est exploité à l'aide de portes quantiques, ainsi que sur les caractéristiques de la lecture du qubit.

Le temps de cohérence d'un qubit peut être divisé en deux échelles de temps différentes, selon l'impact du bruit sur son état. Le temps de relaxation énergétique, T1, indique le temps après lequel l'état du qubit se détend jusqu'à son état de base |0〉, voir la figure 3(a). Ce type de décroissance est non réversible puisque l'énergie quitte le système. Le temps de déphasage, T2, fait référence à l'échelle de temps après laquelle l'état perd ses informations de phase autour de l'équateur de la sphère de Bloch, voir Fig. 3(b). Contrairement à la relaxation de l'énergie, la perte de cohérence de phase peut (dans certaines circonstances) être réversible, en appliquant une séquence de porte de recentrage.

Enchevêtrement et interférence quantique

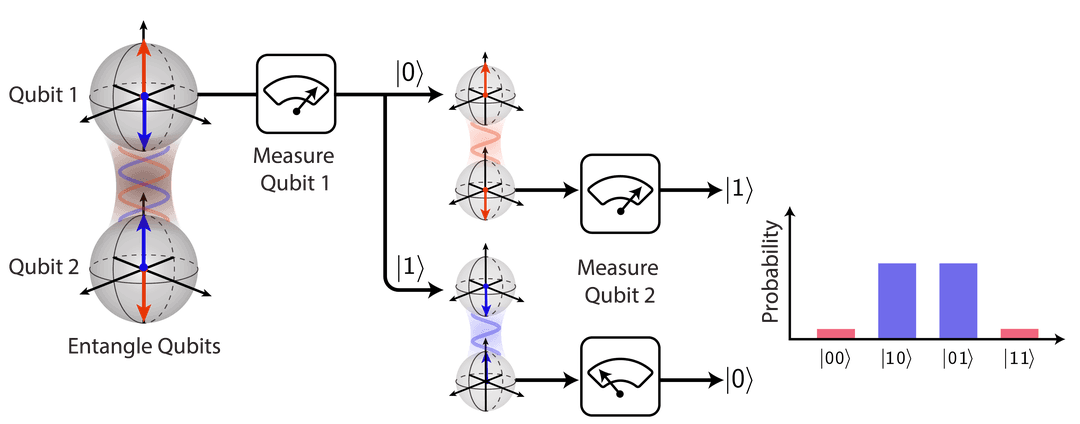

Les états de superposition quantique peuvent également s'étendre à plusieurs systèmes quantiques, de sorte qu'une opération sur un système affecte immédiatement tous les autres. Ce type d'interaction est appelé “enchevêtrement” et fournit aux ordinateurs quantiques leur échelle avantageuse, de puissance de calcul à chaque qubit ajouté.

Pour illustrer cette puissance, il faut considérer le nombre de coefficients complexes nécessaires pour décrire le registre quantique complet. Par exemple, un seul état de qubit peut être représenté par deux coefficients complexes, c0 et c1, correspondant à la probabilité de trouver le système dans les états |0〉 et |1〉, respectivement. De la même manière, pour représenter les états de deux qubits enchevêtrés, nous avons besoin de quatre coefficients complexes, c'est-à-dire c00, c01, c10, c11, etc. En fait, le nombre de coefficients s'échelonne comme 2N, où N est le nombre de qubits. Par exemple, si le registre de qubits contient 300 qubits, le nombre de coefficients est plus grand que le nombre d'atomes dans l'univers connu.

Dans un algorithme quantique, exécuté sur un registre de qubits contenant de nombreux qubits, le résultat attendu contient une distribution statistique entre les probabilités de trouver les qubits dans certains états. Par conséquent, étant donné que les qubits sont enchevêtrés les uns avec les autres, la réponse à la tâche de calcul en question peut alors être obtenue en analysant le modèle d'interférence quantique (ou les corrélations) de ses états de résultat. Ceci est illustré pour deux qubits dans la figure 4.

L’ordinateur quantique remplacera-t-il l’ordinateur classique ?

Les défis liés à la construction d'un ordinateur quantique dépendent de la technologie utilisée. Par exemple, pour les qubits supraconducteurs, sur lesquels travaillent Google, IBM et Rigetti, le défi consiste à mettre à l'échelle le système de manière fiable - tant au niveau de la puce que de son système de contrôle - sans introduire d'interactions indésirables (tant avec l'environnement sous forme de bruit, mais aussi avec d'autres composants du circuit). Lorsque de telles interactions agissent sur les qubits, elles leur font perdre leur cohérence, ce qui conduit finalement à des erreurs dans le calcul quantique. Par conséquent, l'un des principaux défis aujourd'hui est non seulement de continuer à augmenter le nombre de qubits dans le processeur, mais aussi d'améliorer leur qualité. Cela peut se faire sur plusieurs fronts, notamment en utilisant de meilleurs matériaux, en concevant des puces plus adaptées pour les micro-ondes, et en trouvant de meilleurs protocoles de porte pour mettre en œuvre les algorithmes quantiques.

Il existe aujourd'hui plusieurs entreprises qui proposent des processeurs quantiques pour leur service de cloud computing, comme IBM. Bien que la taille et la puissance de calcul de ces processeurs soient limitées et pas encore suffisantes pour des cas d'usage industriel, c'est une bonne façon de commencer à réfléchir à la manière dont les problématiques concrètes peuvent être mise en œuvre sur un processeur quantique.

Jusqu'ici, nous n'avons pas encore atteint le stade de l'informatique quantique universelle à tolérance aux pannes, le type d'algorithmes appliqué actuellement répond à ce qu’il est possible de faire avec le matériel dont nous disposons. Par conséquent, la prochaine application pour les industries sera probablement l'utilisation de systèmes quantiques pour simuler de plus petites molécules, peut-être pour des applications de recherche médicale.

Cela dit, l'ordinateur quantique ne remplacera jamais complètement, c’est fort probable que les ordinateurs classiques. Nous devrions plutôt utiliser des ordinateurs classiques pour résoudre des parties du problème qui sont facilement résolues grâce à cette architecture, alors que l'ordinateur quantique peut prendre en charge certaines sous-routines pour lesquelles un ordinateur classique n'est pas adapté.